Objektbasiertes Audio für 3D Musikproduktion: Stereo Workflow Vergleich

Inhalt

Gastbeitrag zu objektbasiertes Audio für Musikproduktion in 3D im Vergleich zu Stereo von Daniela Rieger

„Although most engineers ultimately rely on their intuition when doing a mix, they do consciously or unconsciously follow certain mixing procedures“ (Owsinski, B. (2006). The Mixing Engineer’s Handbook)

Etablierter Stereo Musikproduktions-Workflow

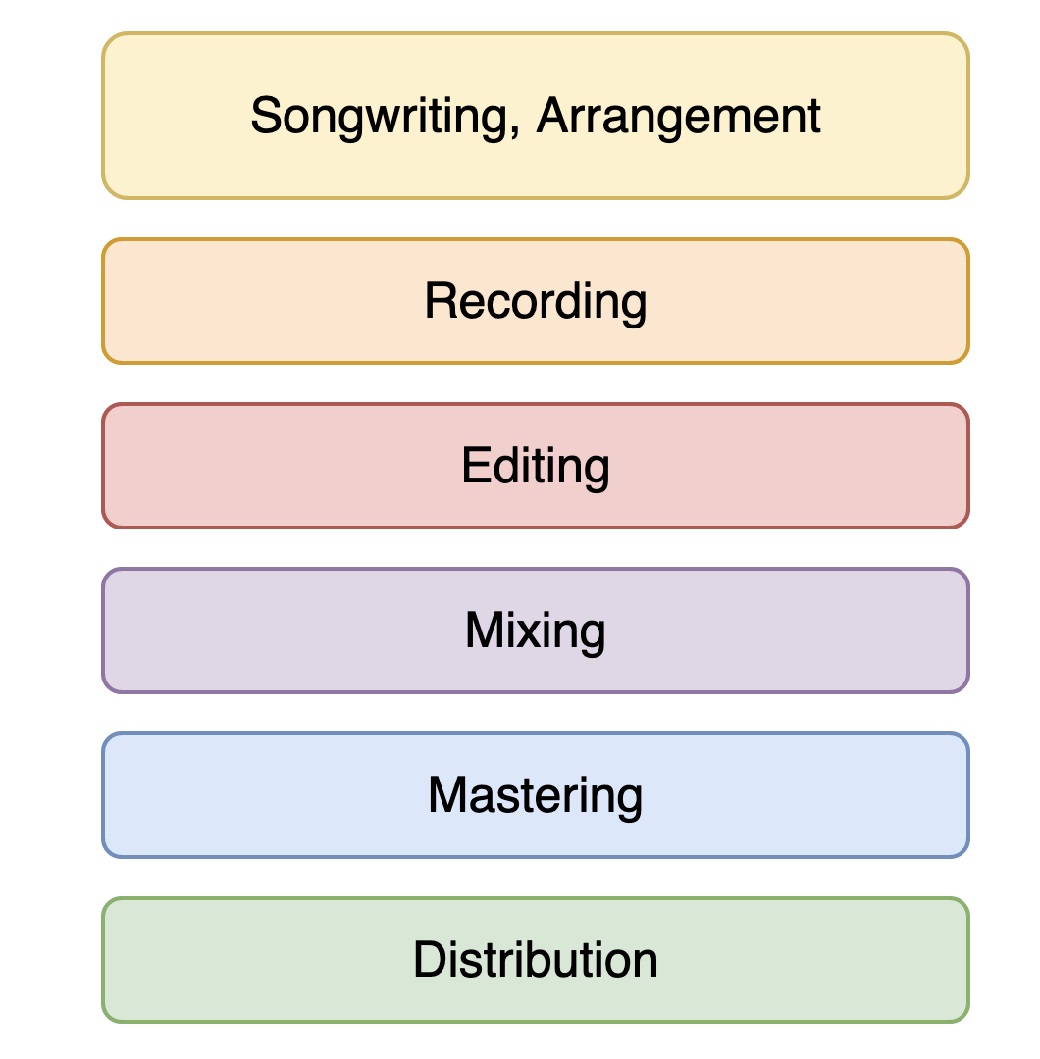

Jede/r Tonschaffende verfügt durch Erfahrungswerte, Präferenzen und eine Vielfalt an weiteren Einflüssen über individuelle Workflows. Diese bewirken zahlreiche unbewusste, zeitliche und materialbezogene Entscheidungen. Nichtsdestotrotz gibt es eine Schnittmenge an allgemeingültigen Vorgehensweisen. Eine übliche Produktionskette bei der Stereo Pop-Musikproduktion könnte im Groben und Ganzen so aussehen:

Auf Grundlage dieses “allgemeinen” Workflows haben sich Parallelen in der praktischen Anwendung von Dolby Atmos Music und 360 Reality Audio gezeigt. Der Workflow für objektbasiertes Audio kann in Produktions- und Distributionsweise, sowie Aufnahme, Editing und einem Teil der Mischung durchaus dem Stereo-Workflow gleichen.

Eine Unterscheidung erfolgt ab dem Punkt, ab dem die objektbasierte Audio Software integriert wird. Das bedeutet: Sobald beispielsweise die Dolby Atmos Production Suite oder der 360 WalkMix Creator (früher: 360 Reality Audio Creative Suite) in der Produktionsumgebung verwendet werden, entstehen neue Workflows – mit neuen Herausforderungen, und neuen Möglichkeiten.

Vergleich der Produktionsweise zwischen Stereo und objektbasiertes Audio

Bevor wir nun die beiden Workflows genauer betrachten, gilt es an dieser Stelle, die Relevanz der Unterscheidung zwischen den Audio-Begrifflichkeiten „immersiv“ bzw. „3D“ und „objektbasiert“ herauszustellen.

Unterschied von „3D“ und „objektbasiert“

Die Unterscheidung des Workflows bei objektbasierten Produktionen zu Stereo-Produktionen erfolgt, wie oben beschrieben, erst mit Integration der entsprechenden Software. Ein immersiver Produktions-Workflow spielt hingegen bereits früher eine Rolle:

Während der Aufnahme kann unter Berücksichtigung von 3D-Aufnahmetechniken eine andere Räumlichkeit geschaffen werden. Diese kann später durch den Einsatz spezieller 3D-Plugins für Hall, Delay, Kompression und Effekte verstärkt herausgearbeitet werden.

Da nicht jede immersive Produktion objektbasiert, jedoch die meisten objektbasierten Audio-Produktionen immersiv sind, wird der Einfachheit halber im restlichen Artikel von letzterer Annahme ausgegangen.

Grafische Gegenüberstellung

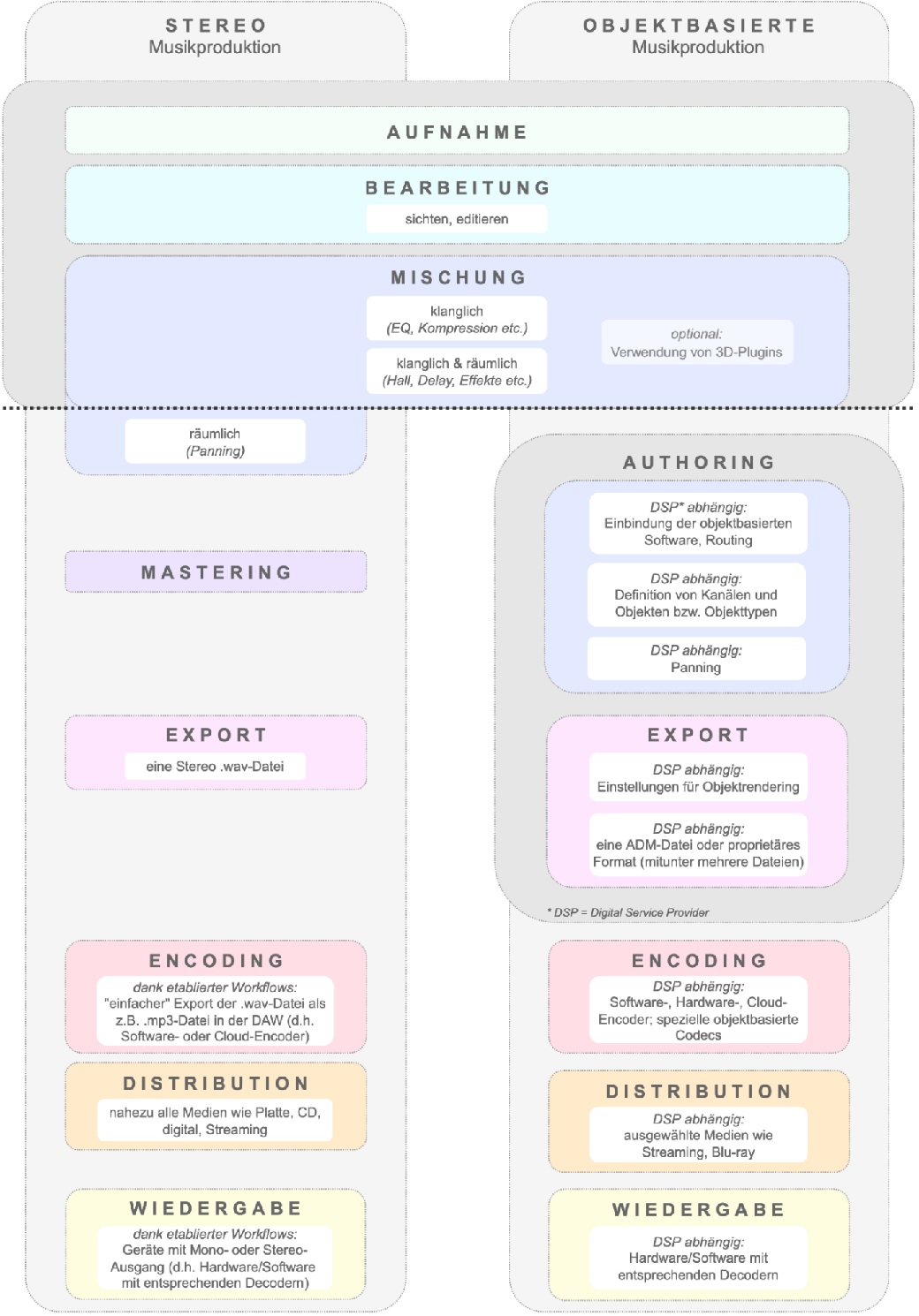

In der Grafik lässt sich erkennen, dass es durchaus Änderungen im Produktions-Workflow gibt, die grundlegenden Schritte jedoch sehr ähnlich bleiben.

Besonders im Schritt “Encoding” und “Wiedergabe” wird deutlich: Die Grundidee, wie diese Prozesse funktionieren, ist gleich. Beide Schritte basieren auf der Verwendung von Cloud-, Software- oder Hardware-Encodern sowie Hard- oder Software-Decodern.

Der größte Unterschied ist einfach der, dass sowohl Encoder als auch Decoder für die herkömmliche kanalbasierte Musikproduktion stark etabliert und “gängig” sind – für NGA befindet sich all dies aktuell im Werden. Es ist schlicht und einfach noch nicht so allgegenwärtig.

Ausgangslage: Stereo-Mischung

Die Gegenüberstellung zeigt: durch Ähnlichkeiten zu Beginn des Produktions-Workflows kann man auch von einer Stereo-Mischung in die objektbasierte Audio Produktion starten.

Die Anlieferung eines DAW-Projektes – sofern es sich hierbei um eine von objektbasierter Software unterstützte DAW handelt – bietet eine Möglichkeit, gestalterische Entscheidungen der Stereo-Mischung beizubehalten, und darauf basierend eine objektbasierte Audio Mischung zu erstellen.

Dies gelingt, da die Produktions-Software (Dolby Atmos Production Suite, 360 WalkMix Creator) in die DAW-Projekte bereits vorhandenen Stereo- oder Surround-Mischungen integriert werden kann.

Die Wahl der DAW beeinflusst aktuell noch die weitere Herangehensweise an die Produktion, insbesondere in Hinblick auf die Verwendung von Aux- oder Audio-Spuren mit größeren Kanal-Konfigurationen als 5.1 (beispielsweise für die Erstellung von Mehrkanal Bett- oder Effektspuren). Hier gibt es je nach DAW Einschränkungen, die allerdings mit Workarounds oder der Verwendung spezieller Tools (Beispiel: SAD von NAT) zu lösen sind.

Neuerungen: Authoring von Metadaten

Die wohl auffälligste Abweichung der Workflows ergibt sich durch den neuen Schritt des Authorings. Dieser beschäftigt sich mit der Erstellung (beispielsweise den Einstellungen zum Objekt-Rendering) und Überprüfung der Metadaten und bringt verschiedene Neuerungen mit sich.

Durch das Zusammenspiel von Audio + Metadaten entstehen verschiedene Vorteile, das bekannteste Stichwort ist sicherlich “flexibles Rendering”: Die Übertragung von Audio + Metadaten sorgt dafür, dass die Mischung am Endgerät flexibel auf das vorhandene Setup angepasst wird. Das bedeutet auch, dass durch die Verwendung von Objekten nicht “nur” eine binaurale Kopfhörer-Mischung gemacht werden kann, sondern eben diese Mischung durch das flexible Rendering auch auf Soundbars oder Lautsprechern wiedergegeben werden kann.

Dieses flexible Rendering führt dazu, dass bei NGA (Next Generation Audio) Monitoring-Output und Export nicht, wie von kanalbasierten Produktionen bekannt, das Gleiche sind.

Das Monitoring im Renderer (Beispiele: Dolby Renderer, 360 WalkMix Plugin, Fraunhofer MHAPi, Auro Renderer,…) ist eine Preview dessen, was im Endgerät passieren wird. Durch die Monitoring-Auswahlmöglichkeiten in den Tools (Stereo, Binaural, 5.1+4H etc.) können verschiedene Renderings vorgehört werden. Diese Renderer-Einstellung und -auswahl ist aber komplett unabhängig vom Export.

Zusätzlich bringt die Funktionsweise objektbasierten Audios mit Metadaten eine weitere Neuerung mit sich: andere Anforderungen an den Mastering-Prozess.

Mastering von Audioobjekten

Das große Thema “Mastering” eröffnet neue technische Anforderungen an mögliche Software-Entwicklungen. Hat sich das herkömmliche, kanalbasierte Mastering über die Jahre zu einem festen Teil der Musikproduktion etabliert, so erfordert objektbasiertes Audio Mastering eine neue Herangehensweise:

Dadurch, dass keine finale Mischung übertragen wird, die bei jedem Konsumenten in der gleichen Art und Weise wiedergegeben wird, sondern eine Kombination aus Audio + Metadaten, kann am Ende der Produktion nicht auf herkömmliche Masteringtechniken zurückgegriffen werden.

Es müssen nicht wie bei kanalbasierten Produktionen Lautsprechersignale, sondern Audioobjekte gemastert werden. Etablierte Konventionen existieren hierfür aktuell noch kaum.

Um objektbasiertes Audio Mastering genauer zu betrachten, sollte dieser allgemeine Schritt in mehrere Einzelteile aufgeteilt werden: Klangliches Mastering (EQ, Kompression), Album-Mastering, Archivierung und Backups sowie Distributions-vorbereitungen. Insbesondere Dynamikbearbeitung (Compressor, Expander, Limiter) entscheidet bei der Musikmischung über den Gesamteindruck.

Wird bei kanalbasierten Mischungen (wie Stereo oder 5.1 Surround) oft mit Bus-Kompression gearbeitet, um einzelne Instrumente, bestimmte Frequenzbereiche oder den Gesamtklang zu komprimieren, so stellt dies bei objektbasierten Produktionen eine erhöhte Schwierigkeit dar, da das flexible Rendering dies nicht zulässt.

Insbesondere der Aspekt des Binaural-Renderings und damit einhergehenden klanglichen Verfärbungen (durch Verwendung verschiedenster Binaural-Renderer) stellt eine weitere Herausforderung dar, da während des Masterings kaum Einfluss darauf genommen werden kann.

Neue Wiedergabemöglichkeiten wie Streaming führen ebenfalls dazu, dass sich der Masteringprozess wandelt: Der Schritt, verschiedene Titel als Album zusammenzuführen, gerät teilweise in den Hintergrund, da Musik-Streaming beim Hörer oftmals titelbasiert erfolgt und nicht durch Wiedergabe eines kompletten Albums. Somit erfolgt Mastering oft nur für einzelne Titel, nicht für ein gesamtes Album – der Schritt des Album-Masterings entfällt teilweise (außer natürlich bei Alben, die komplett immersiv produziert werden).

Ein neuer Mastering Schritt ist außerdem die Überprüfung des Authoring-Prozesses (kor- rekte Formate und Metadaten), Archivierung objektbasierter Mischungen (beispielsweise als ADM-Dateien) sowie die Encodierung in das entsprechende Format und die damit verbundene Vorbereitung für sämtliche Distributions- und Wiedergabewege.

Abhängigkeit von der 3D Audio Technologie

Im Vergleich beider Produktionsarten ist außerdem auffällig, wie sehr die Abweichungen vom herkömmlichen Produktions-Workflow von der jeweiligen zugrundeliegenden objektbasierten Audio Technologie abhängen. Ein Beispiel hierfür ist das Encoding und die daraus resultierende Wiedergabe:

Bei Stereo-Produktionen wird meist eine .wav-Datei exportiert und beispielsweise als AAC- oder mp3-Datei encodiert (welche basierend auf den weitreichend verbauten Decodern nahezu überall wiedergegeben werden kann). Bei objektbasierten Audio Produktionen werden aktuell entweder eine ADM-Datei mit einem speziellen, technologie-abhängigen Profil erzeugt, oder ein proprietäres Format exportiert, welche dann im Encoding-Prozess teilweise in unterschiedliche Formate encodiert wird.

Das ermöglicht, dass die Datei auf unterschiedlichen Geräten wiedergegeben werden kann. Dies zeigt eine der Neuerungen objektbasierten Audios auf: In verschiedenen Schritten des Workflows wird mit speziellen, (noch) nicht kompatiblen Formaten gearbeitet. Der Entscheidungsprozess für eines der Formate liegt im objektbasierten Workflow deutlich früher als in der herkömmlichen Stereo oder 5.1 Surround Produktionskette. Konvertierungstools können hierbei jedoch Abhilfe schaffen und Produktionen von einem Format in ein anderes überführen.

Objekte in der Musikproduktion

Welche Bedeutung Audioobjekte speziell in der Musikproduktion haben können, ist mit der Produktionsart und dem Musik-Genre verknüpft. Das liegt daran, dass sich dieses auf den objektbasierten Produktions-Workflow ähnlich auswirkt wie auf den einer Stereo-Produktion.

Zum einen gilt zu unterscheiden zwischen Live-Produktionen und Studio-Produktionen. Bei einer Jazz- oder Klassikmischung (sowie bei Live-Produktionen) kommt dem Klangkörper im Raum (und somit der Aufnahmetechnik) eine besondere Bedeutung zu.

Im Gegensatz dazu spielt bei einer elektronischen (sowie Studio-basierten) Produktion die Gestaltung und Kombination aufgenommener und synthetisch erzeugter Klangelemente eine größere Rolle.

Live-Produktion, Jazz und Klassik

Insbesondere bei der Aufnahme eines Klangkörpers im Raum kommt es zum Übersprechen zwischen einzelnen Instrumenten, was in der Mischung berücksichtigt werden muss (Delay Compensation), und bei der Verwendung von Instrumenten als einzelne Objekte zu Problemen führen kann.

In Bezug auf objektbasierte Audio Produktionsweisen bedeutet dies, dass sich der Fokus je nach Genre verschieben kann: Bei einer Klassik-Produktion bietet es sich an, dass insbesondere eine präzise Lokalisation einzelner Objekte sowie der Aspekt der Immersion und Räumlich- keit in den Vordergrund rückt: durch die Möglichkeit, den gesamten Raum einschließlich der Höhendimension abzubilden, kann die Akustik verschiedener Konzertsäle dargestellt werden.

In Kombination mit dem flexiblen Wiedergabe-Rendering (beispielsweise der Binauralisierung) bedeutet dies, dass dem Hörer realistischere Hörerlebnisse simuliert werden können. Mögliche Nutzer-Interaktivität bei der Wiedergabe kann ebenfalls dazu beitragen.

Nutzer-Interaktivität ist ein weiteres Feature von objektbasiertem Audio wie z.B. dem MPEG-H 3D-Audio Codec. Im Authoring-Prozess können verschiedene Presets festgelegt werden, die mittels Metadaten definieren, ob und inwieweit Nutzer mit dem Material interagieren können. Im Musikbereich wären Beispiele eine Auswahl der Hörerposition im Raum (Parkett, 1. Rang, Dirigentenposition) oder ein “Play-Along” Presets, bei welchem die Solo-Stimme deaktiviert wird und Nutzer so frei mitspielen könnten.

Studio-Produktion (Pop, Elektro, o.ä.)

Bei „abstrakten“ (beispielsweise elektronischen) Produktionen hingegen können die zumeist einzeln vorliegenden, aufgenommenen oder synthetisch erzeugten Klangelemente als bewegte Objekte in Szene gesetzt und somit eine atmosphärische Klanglandschaft erzeugt werden.

Bei elektronischer Musik bietet es sich außerdem besonders an, eine dreidimensionale Räumlichkeit durch kreatives (in Maßen eingesetztes) Objekt-Panning zu erschaffen. Hier muss nicht – im Gegensatz zu klassischer Musik – auf eine korrekte und realistische räumliche Positionierung und Reproduzierung geachtet werden.

Verschiedene Genres können somit von unterschiedlichen Aspekten objektbasierten Audios profitieren – wobei der Fokus stets auf dem Hörer liegen sollte.

Sind Stereo Gewohnheiten auf 3D Mixe übertragbar?

Insbesondere im Klassikbereich existieren traditionell geprägte und etablierte Hörgewohnheiten, welche auch bei objektbasierten immersiven Produktionen zumindest im Ansatz bedacht werden sollten.

Techniken, die sich bei Stereo-Produktionen bewährt haben, gelten auch für objektbasierte immersive Mischungen. 3D-Audio ist eine Erweiterung von Stereo. Etablierte Produktions-Workflows sind somit weiterhin relevant und können durch neue Produktionstechniken und Möglichkeiten angereichert werden.

Abschließend betrachtet spielt bei objektbasierter Musikproduktion zum einen besonders der immersive Aspekt eine Rolle. Dieser kann gleichzeitig auch eine verstärkte Emotionalität mit sich führen.

Zum anderen bewirkt das flexible Wiedergabe-Rendering, dass erstellte Produktionen vom Konsumenten über Kopfhörer, Soundbars oder Lautsprechersysteme gehört werden können. Personalisierungsmöglichkeiten sind gegeben und somit besteht ein Mehrwert gegenüber rein binaural oder kanalbasiert produzierten immersiven Mischungen.

Fazit

Abschließend lässt sich feststellen: es wird noch einige Zeit dauern, bis sich im Bereich der objektbasierten, immersiven Musikproduktionen ähnliche Konventionen und – zumindest teilweise – standardisierte Workflows etablieren.

Die gewohnten Produktions-Workflows der Stereo-Musikproduktion müssen allerdings nicht grundlegend verändert werden, sondern dienen weiterhin als Basis, auf denen neue Prozesse aufbauen können.

Objektbasiertes Audio bringt viele neue Features mit sich, von der Nutzerinteraktivität, neuen kreativen Möglichkeiten durch den dreidimensionalen Raum bis hin zum flexiblen Rendering. In der Musikproduktion spielen insbesondere letztere beide Punkte eine Rolle.

Im Gegensatz zur herkömmlichen 2-Kanal Stereo-Musikproduktion sind vor allem die Encoding- und Decoding-Prozesse noch nicht allgemeingegenwärtig, und nehmen somit im Workflow eine komplexere Aufgabe ein.

Wie auch bei anderen Next Generation Audio Themen erleben wir jedoch den “Innovationsprozess” der neuen Technologien gerade live mit.

Somit bietet sich jetzt für alle an objektbasierten Musikproduktionen interessierten Tonschaffenden eine gute Möglichkeit, von Anfang an bei diesen neuartigen Workflows mitzumischen – im wahrsten Sinne des Wortes! Wer also dabei sein will und Starthilfe braucht, schreibt mir einfach eine Mail!

Kontakt aufnehmen