Sound Design für Mixed Reality (MR)

Inhalt

Ein Gastbeitrag von Iain McGregor

Mixed Reality bezieht sich auf Technologien, die verwendet werden können, um virtuelle Elemente über die „reale“ Welt zu legen. Mixed Reality bedeutet, dass die reale Welt mit Inhalten angereichert werden kann, um entweder ein erweitertes oder faszinierenderes Erlebnis zu bieten. Wie beispielsweise eine lebensrettende Operation zu leiten oder von einem Dinosaurier gejagt zu werden.

Vielen Dank an Iain, der mir angeboten hat, diesen umfassenden Artikel hier zu veröffentlichen. Dies ist die deutsche Übersetzung.

Plattformen für Mixed Reality (MR)

Derzeit gibt es zwei Haupt Plattformen um MR erleben zu können: am Kopf befestigte Displays Brillen (HMD) und Handheld-Geräte wie Smartphones oder Tablets. Beide Formate nutzen binauralen Stereoklang mit separaten Kopfhörern oder in die Hardware integrierten Lautsprechern bzw. Knochenschall.

Mixed Reality bietet eine große Vielfalt an Möglichkeiten, sich natürlich zu bewegen. Das bedeutet, dass die Nutzer viel mehr Abwechslung in Bezug auf den Klang bekommen können.Anders, als dies bei etablierteren Formen interaktiver Medien der Fall ist.

Akustische Erweiterung der realen Welt

Das Thema Mixed Reality geht auf die 1990er Jahre zurück und umfasst Human Robot Interaction (HRI) / Reality (R), Augmented Reality (AR), Augmented Virtuality (AV) und Virtual Reality (VR).

Es gab bereits mehrere Ansätze mit unterschiedlichen Erfolgen, aber wenn man die akustische Erweiterung der realen Welt betrachtet, ist die Tradition wahrscheinlich so alt wie die Menschheit selbst. Diejenigen, die von ihren Eltern eine Gute-Nacht-Geschichte vorgelesen bekamen, haben bereits “augmented Reality” erlebt.

Die vorgelesenen Geschichten, manchmal unterlegt mit Geräuscheffekten, schufen eine völlig neue Welt. Die meisten von uns haben bis weit ins Erwachsenenalter hinein irgendeine Form der auditiven Erweiterung genutzt. Indem sie eine Form von Audio (Hörbücher, Musik, Podcasts, Radio, Telefon, Turn-by-Turn-Navigation) hörten, während sie eine andere Aufgabe erledigten.

In der Regel ist es möglich, sowohl die reale als auch die virtuelle auditive Welt zu verstehen, selbst wenn das Übertragungsmedium von schlechter Qualität ist, wie z. B. bei einem Mobiltelefon.

Eintauchen in Mixed Reality

Die erste Überlegung für jede Mixed-Reality-Anwendung ist die Hardware. Die Zuhörer können unabhängig vom Gerät in die virtuelle Welt eintauchen, ganz egal ob es sich um einen Monolautsprecher oder eine vollständig personalisierte binaurale Wiedergabe über Kopfhörer handelt. „Immersed in Mixed Reality“ bedeutet, dass Attribute zugeordnet und räumliche Hinweise interpretiert werden können.

Was sind Vorteile von Kopfhörern?

Kopfhörer sind eine beliebte Option für Mixed Reality, und es gibt sie in vielen Formen: von vollständig geschlossenen, die den Hörer von seiner akustischen Umgebung isolieren, bis hin zu vollständig offenen, die die Knochen- oder Knorpel Übertragung nutzen.

Dies ist ähnlich wie bei VR und AR. Eine der besten Analogien für VR sind geschlossene Kopfhörer, während AR eine offene Rückseite hat. Eine der empfohlenen Lösungen zur Verbesserung der VR-Akzeptanz ist die Integration einer eingebauten Kamera, die es den Nutzern ermöglichen könnte, ihre Umgebung bei Bedarf schnell zu betrachten, ohne das Headset abnehmen zu müssen.

Auch geschlossene Kopfhörer können sich dieses Prinzip zunutze machen, indem sie Mikrofone, die für eine aktive Geräuschunterdrückung ausgelegt sind, auf Wunsch so umfunktionieren, dass sie reale Klanginhalte unverändert durchlassen.

Hören wir das Gleiche, was wir auch sehen?

Der Mensch erwartet, deutlich mehr zu hören als zu sehen. Es gibt verschiedene Theorien über den evolutionären Verlust der Kontrolle über die extrinsischen Muskeln der Ohrmuscheln. Eine davon besagt, dass diese Muskeln es dem Menschen ermöglichten, unmittelbarer auf eine Bedrohung zu reagieren: und zwar, indem sie ihn dazu brachten, auf eine Schallquelle zu schauen, während der Kopf auf natürliche Weise gedreht wurde. Um so den akustischen Input für beide nach vorne gerichteten Ohren zu maximieren.

Die Hörtechnologien Stethoskop und Hörgerät wurden beide im 19. Jahrhundert erfunden und können ein „übermenschliches Gehör“ ermöglichen. Diese Geräte können Geräusche verstärken oder interpolieren, die falsch gehört werden könnten. Oder sogar Zugang zu Geräuschen bieten, die normalerweise unhörbar wären. Beide Technologien können leicht in die gemischte Realität integriert werden.

Bluetooth und IoT (Internet of things) Geräte

Bluetooth-Stethoskope mit aktiver Geräuschunterdrückung zur Verbesserung der Verständlichkeit sind weit verbreitet und ermöglichen die spektrale Filterung und Amplitudenkontrolle von typischerweise unhörbaren Objekten. Die Kombination von Hörgeräten mit Bluetooth hat es ermöglicht, sie für weit verbreitete AR zu nutzen, insbesondere bei den diskreten Modellen für das Innenohr.

Jedes Internet-of-Things- (IoT, also Internet der Dinge) Gerät mit einem Mikrofon kann nun potenziell zu einer Klangquelle werden. In Kombination mit Technologien zur Korrektur der zeitlichen Abweichung, wie sie z.B. in Konzertsälen zur Auswahl diskreter Mischungen verwendet werden. Damit kann die Klarheit realer Klänge selbst in hochproblematischen Umgebungen erreicht werden.

Dies ermöglicht nicht nur die Einführung neuer Klangelemente, sondern auch Entscheidungen darüber, welche bereits vorhandenen Klänge hörbar bleiben, verstärkt werden oder sogar unhörbar sind. Es kann ein virtueller Schieberegler zwischen dem Realen und dem Virtuellen geschaffen werden, ähnlich dem Kontinuum der Mixed Reality selbst.

Welchen Vorteil bringen “HRTFs”?

Bei der Verwendung von Kopfhörern hat sich die binaurale Wiedergabe durchgesetzt, um den Effekt der Inkopflokalisierung (IHL) zu verringern, der dazu führt, dass Audioinhalte so klingen, als ob sie zwischen den Ohren erzeugt würden.

Die kopfbezogenen Übertragungsfunktionen (HRTFs) können gemessen und generische Modelle in Software bereitgestellt werden, um die klangliche Illusion zu erzeugen, dass Audioinhalte außerhalb des Kopfes erzeugt wurden. Man spricht auch von Externalisierung. Der Erfolg eines jeden Systems hängt davon ab, wie gut der Kopf des Endbenutzers mit dem bereitgestellten Modell übereinstimmt.

Ein großer Kopf wird Lücken haben, in denen der Klang von links nach rechts springt, während ein kleiner Kopf eine Überlappung zwischen links und rechts haben wird. In der Mixed Reality können auditive Hinweise gezielt eingesetzt werden, um zu ermitteln, welcher HRTF-Satz die größte Genauigkeit für einen bestimmten Endnutzer bietet.

Dies ist besser, als sich auf generische, stark gemittelte Antworten zu verlassen. Denn es werden die anatomische Variationen sowie Reproduktionsvariablen, Hörpegel oder sogar kontextbedingte Ablenkung nicht ausreichend berücksichtigen.

Ein ähnliches Konzept ist der Chaos-Modus in Lern-Tablets, bei dem die Fähigkeiten des Benutzers durch einfache Aufgaben ermittelt werden. Das dient dazu, zu bestimmen, welche Inhalte aufgenommen werden sollen. Maßgeschneiderte HRTFs können ausprobiert und in Echtzeit aktualisiert werden, wenn ein neues Modell benötigt wird.

Produzieren von Mixed Reality Content

Eine Technik zur Erzeugung eines Gefühls von Immersion, ohne sich vollständig auf HRTFs zu verlassen, ist die Verwendung einfacher Mono-Punktschallquellen mit Panning und frequenzbasierten Höhensignalen. Bässe werden mit Objekten assoziiert, die tiefer als der Horizont liegen, und hohe Frequenzen werden oft als über dem Horizont liegend empfunden.

Für diese natürliche Assoziation gibt es gute praktische Gründe. In der Natur sind Hochfrequenzquellen oft in Bäumen (Singvögel) oder zumindest über dem Boden (Vokalisationen) zu finden. Während „Impact-Geräusche“, die einen erheblichen Anteil an niedrigen Frequenzen verursachen, typischerweise näher am Boden stattfinden, wo hohe Frequenzen normalerweise durch Hindernisse absorbiert oder gebrochen werden.

Der Direktschall kann auf diese Weise behandelt werden, während indirekte Reflexionen an das HRTF-Modell weitergeleitet werden, in dem beide Signale einfach überlagert werden.

Mixed Reality in Videospielen?

Für die Gestaltung von Mixed Reality-Audio kann ein Videospiel-Ansatz gewählt werden, der sicherstellt, dass die Elemente entweder “Figur” oder “Grund” sind. Eine Figur steht für etwas, mit dem interagiert werden kann, während der Grund einen akustischen Hintergrund darstellt, der den Kontext liefert.

Die Geräusche im Vordergrund (Figur) werden aktiv wahrgenommen, während die Geräusche im Hintergrund (Grund) normalerweise ignoriert werden. Geräuschereignisse im Mittelgrund werden oft ausgelassen, da sie leicht mit der Figur verwechselt werden können.

Es besteht die Erwartung, dass man mit allem, was deutlich hörbar ist, interagieren kann. Ähnlich verhält es sich mit den Erfahrungen in Mixed Reality. Ein gut durchdachtes System bietet der bereits vorhandenen auditiven realen Welt einen akustischen Raum als Mittelgrund, so dass die Nutzer Elemente je nach Bedarf als Vordergrund oder Hintergrund interpretieren können.

Klangliche “Icons” und “Earcons”

Zwei der gebräuchlichsten Formen des Sounddesigns für klangliche Schnittstellen sind auditive Icons und Earcons. Bei ersteren handelt es sich um eine Art Karikatur der akustisch vermittelten Handlung, die die Interpretation erleichtert. Zweitere sollen eher eine Art musikalische Symbolik darstellen, die erlernt werden muss.

Diese Herangehensweise ähnelt den Geräuschen in Zeichentrickfilmen, wo realistische und musikalische Klänge fröhlich nebeneinander existieren, um die Handlungen einer Figur darzustellen. Wir können diese Muster nutzen, um den Benutzern das Verständnis dafür zu erleichtern, wann ein Geräusch etwas Reales oder etwas Konzeptuelles darstellt.

Die Entscheidung, ob eine Schallquelle „im Kopf fixiert“ werden soll, kann ebenfalls dazu verwendet werden, ein Gefühl von Realität zu vermitteln. Klangquellen, die bei Kopfbewegungen in einer festen räumlichen Ausrichtung verbleiben, werden als in der realen Welt existierend wahrgenommen.iejenigen, die nicht von Kopfbewegungen beeinflusst werden, werden nur als in der erweiterten Welt existierend erlebt.

Time-of-Flight Technologie

Wenn es um glaubwürdige Geräusche geht, kann der Einsatz von Time-of-Flight-Kameras (ToF) in mobilen Geräten eine Vorhersage der akustischen Dimensionen eines kleinen Raums ermöglichen. Ebenso wie von Objekten, die den Schall brechen oder reflektieren können.

Diese Daten können verwendet werden, um beliebige Audioinhalte zu vertonen, einschließlich der Sprache des Nutzers. Das dient dazu, ein Gefühl für die akustische Färbung einer Umgebung zu bekommen. In Verbindung mit einem Dienst, der Objekte erkennt und sie mit einer Absorptionsdatenbank abgleicht, können sogar noch genauere Ergebnisse erzielt werden.

Mithilfe dieser Technologien kann man den Eindruck erwecken, dass die Schallquellen in der realen Umgebung vorhanden sind. Dies wird dadurch erreicht, dass die akustischen Eigenschaften der Schallquellen in Echtzeit verändert werden können, wenn sich der Endnutzer um die virtuelle Schallquelle herum bewegt.

Was ist er “Bauchredner-Effekt” im Kino?

Der sogenannte Bauchredner-Effekt wird im Kino routinemäßig eingesetzt, um eine gleichmäßige Übertragung von Dialogen in manchmal suboptimalen Sitzpositionen zu ermöglichen.

Der Ton, der aus dem Center-Lautsprecher kommt, kann so wahrgenommen werden, als stamme er von der räumlichen Position seiner zugeschriebenen visuellen Quelle. Dies ist eine wichtige Fähigkeit für Menschen, die sich die meiste Zeit in Innenräumen aufhalten. Da es andernfalls aufgrund von Raumreflexionen potenziell schwierig wäre, den Ursprung eines Geräuschs zu identifizieren.

Ein weiterer Faktor, der die Interpretation erleichtert, ist die Echounterdrückung, sodass das direkte Element einer Schallquelle, das vor den Reflexionen eintrifft, den Vorrang erhält.

Welchen Nutzen hat Hand- und Headtracking?

Kopf- oder Geräte-Bewegungen könnten verfolgt werden, um den Audioinhalt zu beeinflussen. Bewegungen, die zeigen, dass ein Nutzer nicht weiß, was er sucht, wie z.B. plötzliche Bewegungen in eine beliebige Richtung, könnten den Inhalt so verändern, dass nur wesentliche isolierte Vordergrundgeräusche wahrgenommen werden.

Kontinuierlichere, kontrollierte Bewegungen hingegen liefern einen kontextuellen Hintergrund. Ein ähnlicher Ansatz kann verwendet werden, um selektive auditive Aufmerksamkeit und Gewöhnung zu simulieren. Klangliche Hinweise, die eine Reaktion auslösen, wie z.B. die Kopfdrehung eines Nutzers, könnten sofort deutlicher werden, während diejenigen, die dies nicht tun, abgeschwächt werden können.

Die Klarheit könnte durch die Betonung der Präsenzfrequenzen (1 – 4 kHz), der Verringerung des Nachhalls, der Erhöhung der Lautstärke oder der Verringerung anderer Klänge in einem ähnlichen räumlichen Bereich und Frequenzbereich erreicht werden.

Auch eine Vergrößerung der zeitlichen Abstände zwischen den Geräuschereignissen kann den Nutzern helfen, sich einen Reim auf das zu machen, was sie gerade erleben. Kurze, sich wiederholende Geräusche sind leichter zu lokalisieren als kontinuierliche, ebenso wie solche mit höheren Frequenzen.

Der Mehrwert von Mixed Reality

Änderung des Fahrzeugmodus

Der Fahrzeugmodus ist eine Standardfunktion in Smartphones, aber er kann so erweitert werden, dass je nach Geschwindigkeit mehr oder weniger Informationen übertragen werden.

Ein Schrittzähler kann überwachen, ob die Fortbewegungsart Gehen, Laufen, Bus, Auto, Fahrrad oder sogar Reiten lautet. Kombiniert man diese Daten mit den bisherigen Vorlieben, dem Standort und der Tageszeit, so könnte der Audioinhalt automatisch von detailliert zu eher oberflächlich übergehen.

Wenn in einem Auto geschwindigkeitsbegrenzende Technologien ignoriert werden, könnten die akustischen Inhalte verlangsamt werden oder sogar leiser gemacht werden, so dass die hörbaren Aspekte des Fahrens bei hoher Geschwindigkeit für den Fahrer deutlicher werden.

Das Spiel mit der Sicherheit…

Sicherheit ist ein idealer Aspekt der auditiven Augmentation in Mixed Reality. Wenn ein Benutzer einer Aufgabe nicht genügend Aufmerksamkeit schenkt, können akustische Aufforderungen ihn dazu ermutigen, die gewünschte Aktion auszuführen.

Wenn der Ton selbst die Ursache für die Ablenkung ist, kann er entfernt, reduziert oder maskiert werden. Ein Telefongespräch kann unterbrochen werden, wobei die Person am anderen Ende der Leitung dann eine einfache Ansage erhält, dass der Gesprächspartner gerade nicht sprechen kann.

Sicherheitswarnungen, wie z. B. Sirenen von Rettungsfahrzeugen oder Feueralarme, können in der korrekten Richtung verstärkt werden, so dass es einfacher ist, ihre Herkunft zu identifizieren und bei Bedarf darauf zu reagieren.

Präzise Verfahren zur Identifizierung von Schallquellen sind mittlerweile verfügbar und werden aufgrund der Beliebtheit von Smart Speakern immer zuverlässiger.

Passt der virtuelle Sound zur realen akustischen Umgebung?

Der Vergleich des Hörereignisses mit der bereits vorhandenen akustischen Umgebung in Echtzeit kann sicherstellen, dass ein relevantes Geräusch fast immer gehört wird. Wenn dies nicht der Fall ist, kann ein Geräusch durch einfache Maßnahmen wie Variationen oder unerwartete neue Klänge besser wahrgenommen werden.

Zur räumlichen Orientierung kann ein Geräusch auch unmittelbar vor dem Hörer eingeführt und dann schnell an die richtige Stelle geschwenkt oder gekippt werden.

In ähnlicher Weise kann eine Lautstärkeveränderung und spektrale Klarheit gewählt werden, so dass die Quelle, wenn sie richtig positioniert ist, ohne Räumlichkeit auf Mono umschaltet. Das führt dazu, dass kleine Kopfbewegungen keine Auswirkungen mehr auf den Klang haben, bis die gewünschte Aktion abgeschlossen ist.

Dies ahmt den Effekt nach, der eintritt, wenn eine Klangquelle vollständig wahrgenommen wird und kognitiv von der akustischen Umgebung isoliert wird, so dass nur noch der Inhalt wahrgenommen wird.

Zum Beispiel, wenn man mit jemandem am Telefon spricht und die auditiven Artefakte nicht mehr hört. Wenn der Inhalt eines Geräusches als bedeutsam empfunden wird, wechselt der Hörer schnell vom kausalen (Quellenidentifikation) zum semantischen (Bedeutung) und nur selten zum reduzierten (klangliche Merkmale) Hörmodus.

Dialog, Musik und Effekte

Audioinhalte für Mixed Reality können alle drei in anderen Medien vorkommenden Stems verwenden: Dialog, Musik und Soundeffekte.

Für Blinde gibt es bereits Technologien, die sie darüber informieren, wer sich vor ihnen befindet. Dieser Ansatz lässt sich nicht nur anwenden, um einem Nutzer den Namen einer Person mitzuteilen, sondern auch als Erinnerung an jede andere relevante Information oder Frage.

Die Unterdrückung von Hintergrundgeräuschen, wie sie für Hörgeräte entwickelt wurde, könnte dann eingesetzt werden, um die Sprache zu verstärken. Oder sogar eine der sich ständig weiterentwickelnden Echtzeit-Übersetzungsanwendungen. Technologien wie Amazons Whispersync könnten nahtlos zwischen dem elektronischen Buch und der Audioversion hin- und herschalten, je nachdem, wie nahe sich der Nutzer an Geräten mit unterschiedlichen Funktionen befindet.

Musik kann entsprechend der akustischen Umgebung oder der jeweiligen Aufgabe verändert werden. Sie kann entweder räumlich an den Raum angepasst werden oder so eingestellt werden, dass sie immer lauter ist als das Grundrauschen.

Sie kann sogar pausiert werden, wenn der Hörer zu sprechen beginnt, einschläft oder sich in Reichweite eines akustischen Notrufsignals befindet.

Eines der ältesten MR Beispiele: Audio-Guides

Audio-Guides sind ein altbewährtes Beispiel für Mixed Reality und werden bereits seit den 1950er Jahren eingesetzt. Sie können sowohl mit WLAN als auch mit GPS verbunden werden, um eine höhere Genauigkeit zu erreichen. In Verbindung mit einem Kompass ist auch eine Orientierung möglich, wodurch jedes große, feste Objekt oder jeder Ort eine leicht zugängliche Mixed Reality-Präsenz erhalten kann.

Unternehmen und andere Einrichtungen können selbst entscheiden, wie sie akustisch dargestellt werden möchten. Ein Konzertsaal könnte eine Probe übertragen, während ein Restaurant den Geräuschpegel der Küche und des Speiseraums miteinander verschmelzen lassen könnte, um zu vermitteln, wie viel Betrieb dort herrscht.

Auch andere Formen regelmäßig aktualisierter, allgemein verfügbarer Daten können genutzt werden. In Abbiege-Navigationssystemen könnte der Klang von Verkehrsgeräuschen Autofahrern oder sogar Fußgängern helfen, die richtige Route zu wählen. Dies könnte auf der Grundlage räumlicher Informationen geschehen, die den Grad der Verkehrsüberlastung, der Umweltverschmutzung oder sogar der Geschwindigkeitsbegrenzung angeben.

Audiodeskription (akustische Bildbeschreibung)

Viele Medien verfügen heute über Audiodeskriptionen, die automatisch ausgewählt werden können, wenn sie verfügbar sind. Ebenso könnte eine stärkere Dialogmischung übertragen werden, wenn ein Umstand festgestellt wird, der das Hören erschwert, z.B. eine eingeschränkte Hörfähigkeit oder ein hohes Grundrauschen.

Für den Fall, dass der Inhalt in einer Sprache vorliegt, die der Nutzer nicht spricht, können Übersetzungen eingefügt werden. In vielen Ländern gibt es seit mindestens zehn Jahren eine Gesetzgebung, die Hörverluste als Behinderung einstuft. Was bedeutet, dass Einrichtungen oft ein Hörschleifensystem bereitstellen müssen.

Die Telefonspule oder T-Einstellung an Hörgeräten ermöglicht den Zugang zu dieser Audioübertragung, und viele Unterhaltungs-, Geschäfts- und Bildungseinrichtungen verfügen bereits über aktive Mikrofone, um Stimmen zu verstärken.

Dabei kann es sich um ein einfaches Mikrofon auf der Bühne handeln, das den Ton in den Green Room zurückleitet, wo die Schauspieler darauf warten, auf die Bühne gerufen zu werden.

Selbst bei voraufgezeichneten Inhalten wie Filmen oder Fernsehsendungen ist der Center-Kanal einer Surround-Sound-Mischung in der Regel der Sprache gewidmet, mit wenigen Soundeffekten. Diese bereits vorhandenen Technologien lassen sich leicht einsetzen, um das Hörerlebnis jeder Person in Reichweite zu verbessern. Das am Fraunhofer IIS entwickelte Verfahren “Dialog+” nutzt einen ähnlichen Ansatz

Verräumlichung von Warnhinweisen

Die Verwendung von Kopfhörer-basierten Audiotechnologien bedeutet, dass einfache Techniken wie etwa die räumliche Darstellung von Warnhinweisen Informationen darüber liefern können, wo sich der Absender einer Nachricht in Bezug auf den Nutzer befindet.

Auch die wahrgenommene Dringlichkeit, die sich aus den Antwortzeiten auf frühere Nachrichten ergibt, kann erfasst werden. Ein lauter Ton ist in der Regel wichtiger, ebenso wie ein Ton mit voller Bandbreite und größerem Obertongehalt.

Natürliche Assoziationen mit dem Inhalt der Nachricht oder dem Absender können einbezogen werden, so dass der Inhalt der Kopfzeile sofort verstanden wird. Dies können beispielsweise Karikaturen sein, um humorvolle Inhalte zu vermitteln, Motoren von Fahrzeugen für Lieferungen oder bei ernsteren Themen einfach das Ausblenden oder Stummschalten vorhandener Geräusche.

Das Prinzip kann auch genutzt werden, um Eltern automatisch zu informieren, wenn ein Kind den gewünschten Bereich verlassen hat. Auf diese Weise können die Eltern die Stimme des Kindes aus der richtigen Richtung hören.

Maskierung unerwünschter Geräusche

„Augmented Sounds“ können dazu verwendet werden, unerwünschte Geräusche zu maskieren. Auf diese Weise lässt sich eine Umgebung angenehmer gestalten, so wie es viele Hörer regelmäßig mit Musik handhaben.

YouTube ist bereits eine beliebte Quelle für Vogelgezwitscher, Café-Umgebungen und sogar Kaminfeuer. Es könnte aber auch jedes andere Geräusch mit entsprechenden Assoziationen verwendet werden, z. B. das Schnurren einer Katze, spielende Kinder oder ein Sportereignis.

Neue auditive Elemente könnten auch einen Kontext bieten, um sich wiederholende alltägliche Geräusche durch mehr Abwechslung interessanter zu machen. Das kontinuierliche weiße Rauschen des fernen Verkehrs kann moduliert werden, um es in Wellen an einem Strand zu verwandeln.

Bei einer Klimaanlage könnte das Knacken von Eis unterschiedlich laut sein, um die Wirkung auf die durchströmende Luft anzuzeigen.

Geräusche können leicht modifiziert werden, um eine andere Geschichte zu erzählen, z. B. Stimmen, die sich im Wind verstecken, oder Autos, die sich in Raumschiffe verwandeln. Dies ist vergleichbar mit der Vielzahl von AR-Kameraeffekten, die derzeit für Smartphones verfügbar sind.

Mixed Reality in der Medizin

Die wahre Stärke von Sound in Mixed Reality kommt in Umgebungen wie Krankenhäusern zum Vorschein. Die meisten Geräte in einem Krankenhaus machen zwangsläufig Geräusche, ob absichtlich oder unabsichtlich.

Der Bedarf an leicht zu reinigenden Oberflächen und offenen Grundrissen kann zu einer äußerst stressigen akustischen Umgebung führen, die Personal, Patienten und Besucher gleichermaßen beeinträchtigt. Akustische Warnungen könnten in ein virtuelles Medium übertragen werden, wo sie nur dann in der realen Welt hörbar werden, wenn sie nicht schnell genug beachtet werden.

Wie kann Audio in der Medizin genutzt werden?

Das Personal kann mit offenen Kopfhörern ausgestattet werden, um alle erforderlichen Technologien zu überwachen, die räumlich in der richtigen Ausrichtung dargestellt werden. Die Reaktionszeiten werden verbessert, da komplexe Nachhallgeräusche die genaue Interpretation der räumlichen Position der Quelle nicht behindern.

Erweiterte auditive Inhalte können dargestellt werden, um Handlungen zu leiten, wenn man sich der Schallquelle nähert. Dies trägt zur Vermeidung von Bedienungsfehlern bei, gewährleistet die Privatsphäre und reduziert die Lärmbelästigung.

Die akustische Darstellung des Zustands eines Patienten sollte genauso vertraulich sein wie seine medizinischen Aufzeichnungen. In einigen Intensivstationen liegt der durchschnittliche Schalldruckpegel unabhängig von der Tageszeit immer mindestens 5 dB über den Empfehlungen der Weltgesundheitsorganisation, was zu einem Schlafentzug bei den Patienten führt, was sich bekanntermaßen negativ auf die Genesung auswirkt.

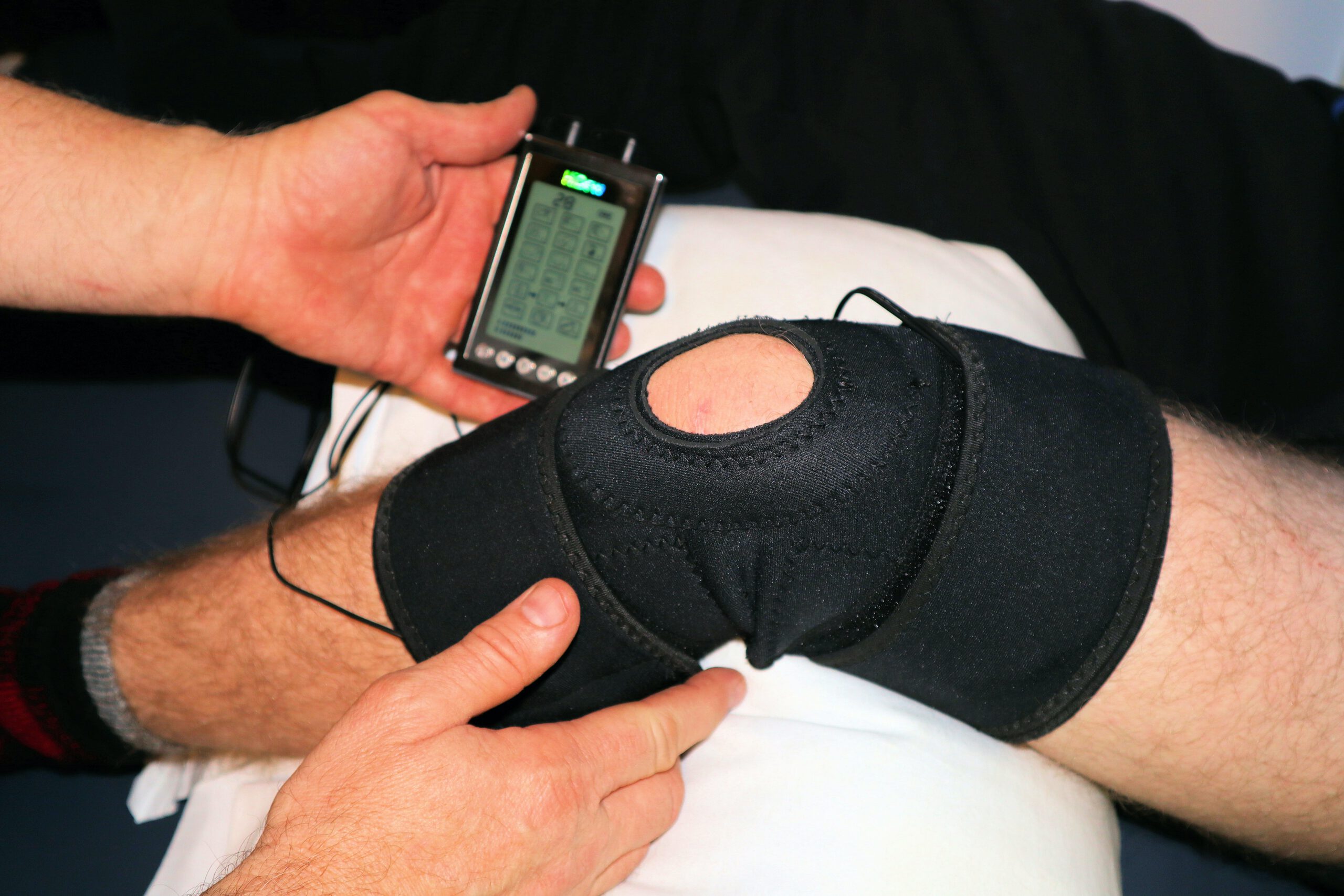

Wie kann MR bei Physiotherapie oder chronischen Krankheiten helfen?

Weitere medizinische Anwendungen sind die Physiotherapie und chronische Krankheiten wie Parkinson. In beiden Fällen können Klänge zur Unterstützung der Bewegung eingesetzt werden.

Die mit der Parkinson verbundenen Probleme beim Gehen können teilweise durch synthetische Echtzeit-Signale gelindert werden. Diese stellen die Schritte gesunder Erwachsener dar und helfen so, Probleme mit der inneren Uhr des Patienten zu überwinden.

In der Physiotherapie können Techniken aus dem Sport übernommen werden. Die korrekten Bewegungen werden von Therapeuten ausgeführt, die Sensoren tragen. Diese Bewegungen können vertont werden, sodass Patienten, die ebenfalls Sensoren tragen, diese nachahmen können. Dabei können sie hören, wie gut die von ihnen erzeugten Geräusche mit den richtigen Bewegungen übereinstimmen.

Dies ähnelt dem Musikunterricht, bei dem ein Lehrer synchron spielt, um unmittelbare Erfolge zu erzielen. Bei allen Erkrankungen, die mit Sensoren überwacht werden, können die Daten mit Tönen unterlegt werden, um die Patienten zu Verhaltensänderungen zu ermutigen. Beispiele dafür sind zu langes Stehenbleiben oder die Warnung vor Überanstrengung.

Es können Erinnerungen an Handlungen wie die Einnahme von Medikamenten oder an grundlegende Körperfunktionen gegeben werden.

Sogar Schmerzen und Stress können durch die Einführung geeigneter Geräusche bei Bedarf reduziert werden. Diese können durch die Messung des Hautsalzgehalts überwacht werden, wobei die verschiedenen Optionen automatisch abgespielt werden, bis die effektivste Geräuschquelle gefunden ist.

Schwitzen mit Mixed Reality: Sport-Anwendungen

Alle Sportarten profitieren davon, dass die Teilnehmer das Geschehen mitbekommen, und die Datenerfassung hat sich in fast allen Disziplinen durchgesetzt. Traditionell hat nur das Trainerteam Zugang zu den Informationen, aber sie könnten problemlos in Echtzeit an die Sportler weitergegeben werden.

Die einseitige Funkkommunikation zwischen Trainern und bestimmten Spielern ist in Sportarten wie American Football seit Jahrzehnten Standard. Die Sonifikation kann genutzt werden, um jede Form von messbarer Aktion darzustellen.

Der Bereich des Wearable Computing weitet sich allmählich aus. So gibt es jetzt Ganzkörperanzüge mit mehreren Sensoren, die diskrete Bewegungen in den gewünschten Teilen der Anatomie überwachen.

Für Skischuhe sind Drucksensoren erhältlich, die in Echtzeit ein auditives Coaching als eine Form der Gamification zur Leistungssteigerung bieten. Weitere Verbesserungen sind möglich, wie z. B. die Verfolgung der relativen Position zu einer Lawine und die entsprechende Beratung der Skifahrer.

Dies kann so einfach sein wie das Ändern des Pannings von Audioinhalten wie Musik oder einem Telefongespräch, um die Bewegung in eine andere Richtung zu fördern.

Fazit

Mixed Reality ermöglicht es den Hörern zu wählen, ob sie ihre akustische Umgebung erweitern oder durch eine andere ersetzen wollen, um eine einzigartige Klanglandschaft zu schaffen.

Sie können diese Möglichkeit verwenden, um mehr zu hören als je zuvor. Dazu können sie die Mikrofone nutzen, die in die ständig wachsende Zahl von IoT-Geräten eingebaut sind.

Alternativ können die Endnutzer ihr akustisches Erlebnis durch Maskierung verändern, so dass sie deutlich weniger hören. Der Unterschied zu der bloßen Isolierung mit passiven Kopfhörern besteht darin, dass die eigenen Handlungen des Hörers sowie die Ereignisse in seiner Umgebung mit Mixed Reality den Klang verändern können.

Jede Form von Echtzeitdaten, die von Sensoren erfasst werden, kann zur Beeinflussung des auditiven Inhalts verwendet werden. Diese können von einfacher Unterhaltung über Leistungssteigerungen bis hin zu lebensrettenden Maßnahmen reichen, wobei die bereits vorhandene akustische Umgebung weiterhin in Verbindung mit allen anderen verfügbaren Sinnen wahrgenommen werden kann.

Die akustischen Aspekte der Mixed Reality können nicht nur übermenschliche Fähigkeiten ermöglichen, sondern auch Erholung und Sicherheit garantieren. Und das alles basierend auf einem Prinzip, mit dem wir alle bereits vertraut sind.

Jetzt Kontakt aufnehmen