App für Blinde SmartAis: LiDAR-Scanner + KI = akustische Gefahrenerkennung

Ich taste mit der Spitze des Blindenstocks über das Kopfsteinpflaster. Doch diesmal bin nicht ich blind, sondern nur für ein paar Minuten künstlich blind gemacht.

Unter meiner Schlafmaske rauscht der Verkehr, als stünde ich mitten auf einer vielbefahrenen Kreuzung. Die Geräusche, die ich als sehender Mensch problemlos sortieren kann, werden auf einmal zu einer bedrohlichen Wand aus Lärm.

Ich weiß, es steht jemand neben mir, ich werde nicht überfahren, aber mein Körper glaubt etwas anderes. In diesem Moment verstehe ich zum ersten Mal körperlich, wie es ist, wenn ein Blindenstock zwar den Boden abtastet, aber nicht vor dem warnt, was auf Hüfthöhe plötzlich im Weg steht.

Diese Erfahrung verdeutlicht, wie wichtig gezielte Unterstützung für blinde und sehbehinderte Menschen im Alltag ist.

Aus genau diesem Gefühl ist das entstanden, worüber ich hier erzählen möchte. Ein System, das blinde Menschen nicht führen soll wie ein Navi, sondern sie an genau den Stellen warnt, an denen ihr Blindenstock an seine Grenzen kommt.

Die Entwicklung dieses Systems erfolgte als direkte Reaktion auf die alltäglichen Herausforderungen, denen blinde und sehbehinderte Menschen begegnen.

Warum

Die eigentliche Stolperfalle

Als mich ein Startup aus München ansprach, brachten sie eine scheinbar einfache Frage mit. Sie wollten wissen, was die größte Stolperfalle für blinde Menschen im Alltag ist. Meine erste spontane Antwort war Bordsteinkante oder unebenes Pflaster. Die Realität ist jedoch eine andere.

Der Blindenstock ist sehr gut darin, den Boden abzutasten. Unebenheiten, Kanten und kleine Hindernisse auf dem Weg lassen sich damit erstaunlich gut erkennen.

Für die Navigation im Alltag sind jedoch sichere Wege und zuverlässige Verbindungen besonders wichtig, damit blinde und sehbehinderte Menschen sich selbstständig und sicher orientieren können.

Das größte Problem sind Dinge, die höher liegen. E Scooter quer über den Gehweg gelegt, Laderampen von Lastwagen, Poller, die nicht markiert sind, Äste, die in den Weg ragen. All diese Hindernisse liegen genau in dem Bereich, den der Blindenstock oft nicht erfasst, der aber für den Körper schmerzhaft wird.

Blinde Menschen entwickeln feste Routen, die sie immer wieder gehen. Auf diesen Wegen kennen sie jede Ecke, jede Ampel und jede Bordsteinkante. Besonders an Straßenkreuzungen stellt die Navigation eine große Herausforderung dar, da hier viele unerwartete Hindernisse und Veränderungen auftreten können.

Wirklich gefährlich wird es erst, wenn sich auf diesen vertrauten Wegen etwas verändert. Wenn gestern kein E Scooter da war, er heute aber quer im Weg liegt. Genau da entstehen Stürze, Verletzungen und Unsicherheit.

Was es schon gibt

Ich habe mir genauer angeschaut, welche Hilfsmittel es bereits gibt. Das taktile Bodenleitsystem kennt jeder, der schon einmal durch einen Bahnhof gelaufen ist. Längsrillen im Boden führen wie eine Schiene, Noppenfelder markieren Abzweigungen oder Übergänge.

Mit dem Blindenstock lassen sich diese Muster gut ertasten. So können blinde Menschen zuverlässig zu Ampeln oder Bahnsteigen geführt werden.

Akustische Ampeln sind ein weiteres Beispiel. Ein leiser Takt klickt vor sich hin und signalisiert, dass hier ein Übergang ist. Wird es grün, wechselt das Signal in einen schnelleren Rhythmus.

Unter dem Taster sitzt ein kleiner Pfeil, den man mit der Hand spüren kann. Er zeigt, in welche Richtung die Straße verläuft, auch wenn diese schräg liegt.

All diese Systeme sind großartige Hilfen. Doch sie sind fest in der Infrastruktur verankert. Als Ergänzung zu diesen traditionellen Assistenzsystemen bieten moderne Technologien wie Barcodes, QR Codes und digitale Karten innovative Möglichkeiten, um die Orientierung und Teilhabe blinder und sehbehinderter Menschen weiter zu verbessern.

Spezielle GPS-Apps und Navigations-Apps mit vielfältigen Funktionen, wie Sprachausgabe, Umgebungsbeschreibung und barrierefreie Navigation, bieten zusätzliche Vorteile und erhöhen die Selbstständigkeit und Sicherheit im Alltag. Sie wissen nichts von dem E Scooter, den jemand heute Morgen sorglos direkt in die Spur gestellt hat. Genau da setzte unsere gemeinsame Idee an. Wir wollten nichts ersetzen, sondern eine Lücke schließen.

Wie

Die Idee mit dem Lidar

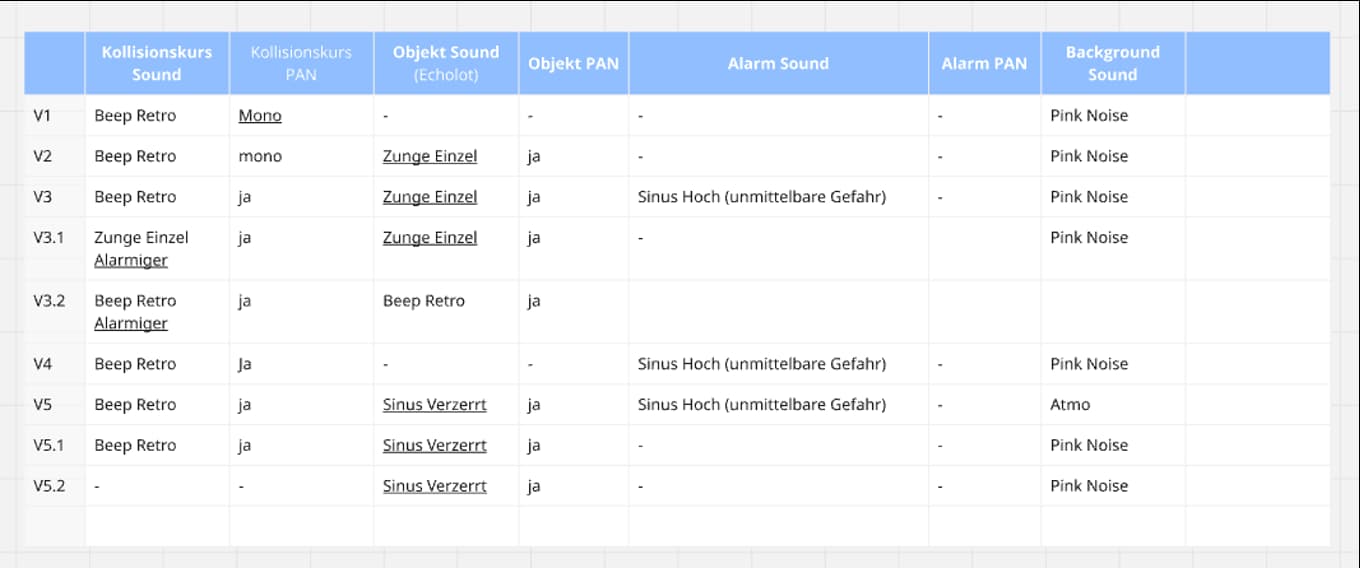

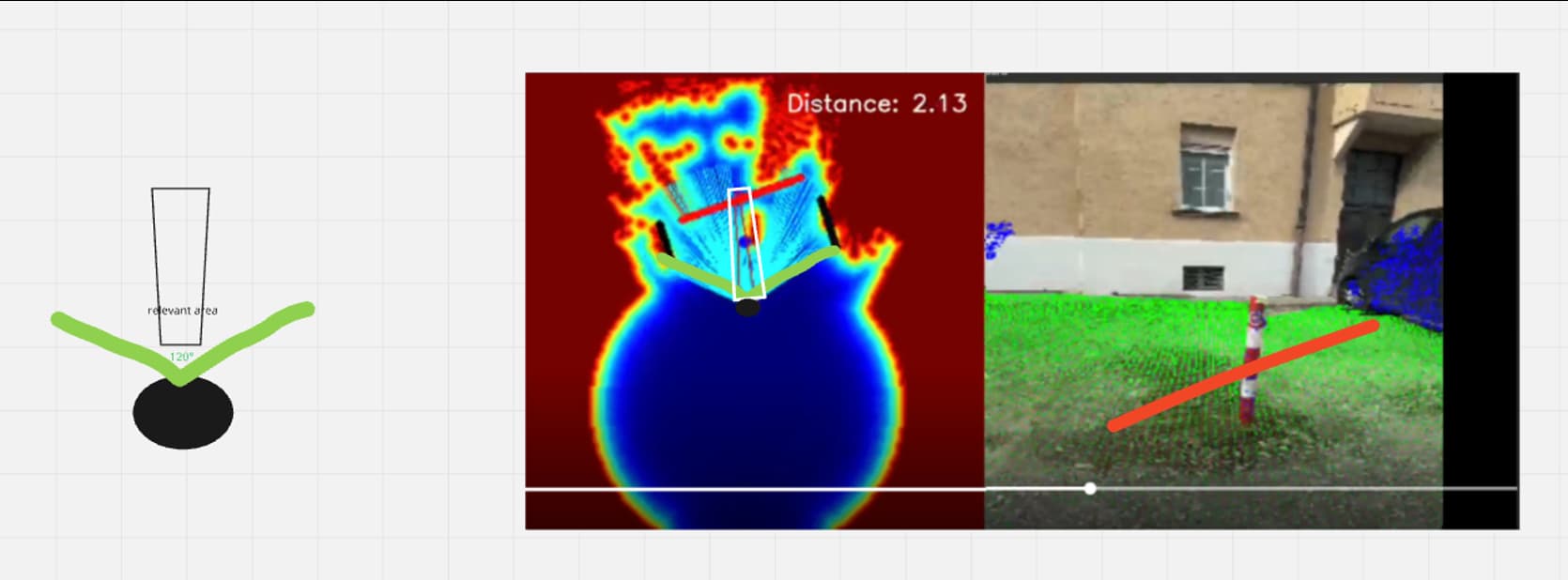

Das Startup war schon ziemlich weit, als sie zu mir kamen. Sie hatten eine App gebaut, die den Lidar Scanner moderner Smartphones nutzt. Dieser Sensor sitzt beim iPhone neben der Kamera und schickt unsichtbare Lichtimpulse in die Umgebung. Aus der Laufzeit der Reflexionen berechnet das System die Entfernung zu Objekten. Es entsteht eine einfache Tiefenkarte.

Die Entwicklung der App basiert auf moderner Künstlicher Intelligenz und fortschrittlicher Programmierung, wodurch innovative Technologien für die Objekterkennung und Navigation ermöglicht werden.

Zusätzlich werden Foto- und Texte-Erkennung integriert, sodass Nutzer Fotos aufnehmen oder hochladen können, um Inhalte automatisch analysieren und beschreiben zu lassen. Die Funktion ‚My AI‘ erweitert die App um KI-gestützte Assistenz, die Bilder und Situationen für sehbehinderte Menschen beschreibt.

Auf dem Smartphone sieht das dann so aus: Das Kamerabild wird angezeigt, darüber legt sich eine Farbebene. Alles, was als Boden erkannt wird, ist grün. Wände oder Hindernisse tauchen in anderen Farben auf. Sogar E Scooter lassen sich als eigene Form erkennen.

Meine Aufgabe war, aus dieser visuellen Analyse ein sinnvolles Audiosystem zu machen. Es sollte blinde Menschen im Alltag unterstützen, ohne sie zu überfordern oder zu verwirren.

Führen oder warnen

Ich habe mir zuerst angeschaut, wie blinde Menschen sich mit Hund und mit Stock orientieren. Ein Blindenhund führt aktiv. Man soll sprichwörtlich den Bewegungen des Hundes folgen. Der Hund sorgt dafür, dass man nicht gegen Hindernisse läuft.

Der Blindenstock funktioniert genau umgekehrt. Er will, dass man gegen das Hindernis stößt, allerdings früh genug und kontrolliert. Erst durch diesen Kontakt versteht man, wo etwas im Weg steht.

Übertragen auf Audio bedeutet das. Entweder ich baue ein System, dem man wie einem Hund folgt. Oder ich baue ein System, das wie der Blindenstock vor Gefahren warnt.

Wir haben beide Ideen durchgespielt. Ein Klang, dem man folgt, klingt verlockend. So etwas kennt man aus Videospielen. In einem Rennspiel kündigt ein Ton an, wann man bremsen oder lenken sollte.

Auf einer echten Straße mit unvorhersehbaren Hindernissen wird es jedoch heikel. Sobald ein System aktiv den Weg vorgibt, entsteht eine Art Haftungsversprechen.

Wenn ich jemanden mit einem Ton nach rechts ziehe und dort tatsächlich eine Straße statt eines Gehwegs liegt, wird es im schlimmsten Fall lebensgefährlich. Damit wollten wir sehr vorsichtig umgehen.

Deshalb haben wir uns für das Prinzip des Blindenstocks entschieden. Das System soll nicht sagen, wohin man gehen soll. Es soll nur sagen, wo etwas im Weg steht.

Bei der Navigation werden akustische Anweisungen und eine klare Sprachausgabe genutzt, um blinde und sehbehinderte Menschen sicher zu führen.

Zusätzlich bietet die App verschiedene Funktionen, wie die Anzeige relevanter Punkte (Points of Interest), die Markierung von Wegen und die Verbindung zu anderen Diensten, um eine umfassende und barrierefreie Navigation zu ermöglichen.

Der relevante Korridor

Wir definieren einen schmalen Korridor direkt vor der Person. Er ist ungefähr so breit, wie man beim Gehen tatsächlich Platz braucht. Der Lidar Scanner deckt einen viel größeren Bereich ab, aber das meiste davon ist gar nicht relevant.

Spannend ist nur das, worüber man in den nächsten Schritten stolpern würde.

Sobald in diesem Korridor ein Hindernis auftaucht, setzt das System dort eine Klangquelle. Dabei reicht eine grobe Auflösung. Vorne, vorne links oder vorne rechts ist für die meisten Nutzerinnen und Nutzer vollkommen ausreichend.

Super exakte Winkel wie 37 Grad bringen mehr Verwirrung als Klarheit.

Das Smartphone wird in einer Halterung vor der Brust getragen, leicht nach unten geneigt. So sieht der Sensor den Boden und die ersten Hüfthöhen gut. Über Bluetooth sind Kopfhörer verbunden. In vielen Tests haben wir gemerkt, dass Knochenschall Kopfhörer eine gute Lösung sind.

Die Ohren bleiben frei, die Umwelt bleibt hörbar. Die Klangqualität ist begrenzt, aber das ist in diesem Fall weniger wichtig als die Verständlichkeit des Signals.

Gerade für blinde und sehbehinderte Menschen bietet diese App einen wichtigen Beitrag zur Mobilität, da sie die selbstständige Orientierung und sichere Fortbewegung im Alltag unterstützt.

Klang statt Hightech Show

Die erste Frage, die mir viele stellen, lautet, ob der Sound binaural und super dreidimensional ist. Die Antwort ist ganz bewusst nein. Ich liebe dreidimensionalen Klang, aber hier steht Funktion über Effekten.

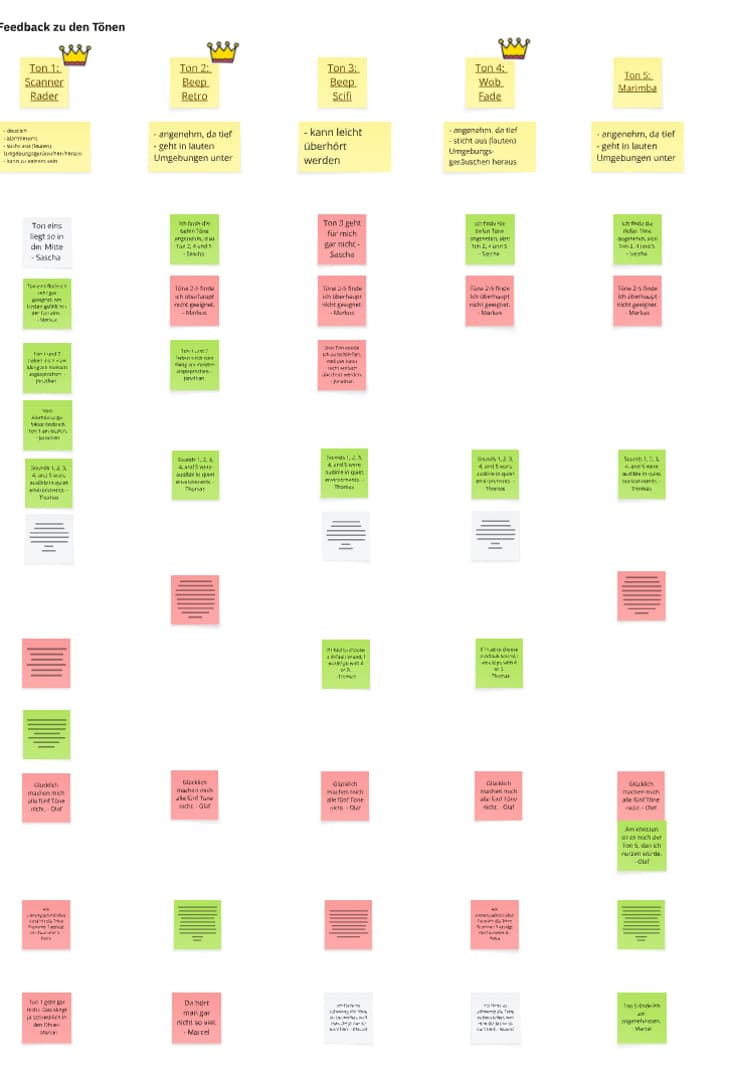

Wichtiger war, einen Ton zu finden, der klar als Warnsignal verstanden wird. Er sollte nicht zu sehr an bekannte akustische Systeme erinnern. Ein Klang, der wie eine Ampel klingt, wäre verwirrend. Ein Dauerton wie beim Rückfahrwarner von Autos wäre auf Dauer zu aggressiv.

Gemeinsam mit meinem Team habe ich verschiedene Klänge gebaut. Dezente Klicks, synthetische Piep Töne und Sounds, die ein wenig an Echolot erinnern. Wir haben diese Varianten mit blinden Nutzerinnen und Nutzern getestet.

Am Ende hat sich eine Mischung aus Pop und Klick durchgesetzt. Der Klang wirkt organisch, lässt sich gut vom Straßenlärm unterscheiden und nervt nicht sofort.

Ein klarer Vorteil dieses Sounds ist, dass er die Bedienung für Menschen mit Sehbehinderungen erleichtert und die akustische Orientierung verbessert. Allerdings können bei bestimmten Umgebungsgeräuschen auch Probleme bei der eindeutigen akustischen Unterscheidung auftreten.

Was

So funktioniert das System im Alltag mit Barrierefreiheit

Im Alltag läuft das System auf einem Smartphone, das in einer Brusthalterung sitzt. Die Person trägt weiterhin ihren Blindenstock, denn der bleibt das wichtigste Werkzeug. Die App ist ein zusätzliches Assistenzsystem.

Zu den wichtigsten Funktionen der App zählen die Sprachausgabe für Umgebungsinformationen, die Bereitstellung von akustischen Anweisungen zur Navigation, die Anzeige und akustische Vermittlung von relevanten Punkten wie Points of Interest, die Erkennung und Darstellung von Wegen sowie die Verbindung zu anderen Diensten und Navigationssystemen.

Während die Person ihren gewohnten Weg entlanggeht, analysiert der Lidar Scanner ständig den Bereich vor ihr. Der Algorithmus entscheidet, ob ein Objekt im relevanten Korridor liegt und ob es eine Stolpergefahr oder ein Zusammenstoßrisiko darstellt.

Ist das der Fall, ertönt der Warnsound aus der Richtung des Hindernisses. Zusätzlich erkennt das System nicht nur Hindernisse, sondern auch andere relevante Gegenstände und weist akustisch darauf hin. Über verschiedene akustische Signale wird das aktuelle Geschehen in der Umgebung vermittelt, sodass Nutzer stets über wichtige Ereignisse informiert sind.

Das System kann gezielt zur Suche nach bestimmten Objekten oder Hinweisen eingesetzt werden, um die Orientierung und Zielerreichung zu unterstützen. Verschwindet das Objekt aus dem Korridor, verstummt der Ton.

Für Treppen oder starke Höhenunterschiede haben wir einen eigenen Klang entwickelt. Viele blinde Menschen können Treppen gut nutzen, sobald sie wissen, dass eine Treppe da ist. Der spezielle Ton signalisiert, dass es gleich bergab geht. So lässt sich der Bewegungsablauf anpassen, bevor die Kante kommt.

Außenräume zuerst

Im Moment ist das System vor allem für den Außenbereich gedacht. Innenräume sind sehr komplex, voller Möbel, enger Gänge und ständig wechselnder Objekte. Draußen auf Gehwegen ist das Szenario klarer.

Viele blinde und sehbehinderte Menschen nutzen GPS-Apps wie Google Maps, BlindSquare und andere Navigations-Apps in Verbindung mit digitalen Karten, um ihre Mobilität und Unabhängigkeit zu verbessern und sich auf Wegen und an Straßenkreuzungen besser zu orientieren. Die vorgestellte App dient dabei als sinnvolle Ergänzung zu diesen Technologien.

Das eigentliche Ziel ist, Veränderungen zu melden, nicht jeden Schritt zu begleiten. Wenn ein Weg frei ist, bleibt die App still. Erst wenn etwas Neues im Weg steht, meldet sie sich.

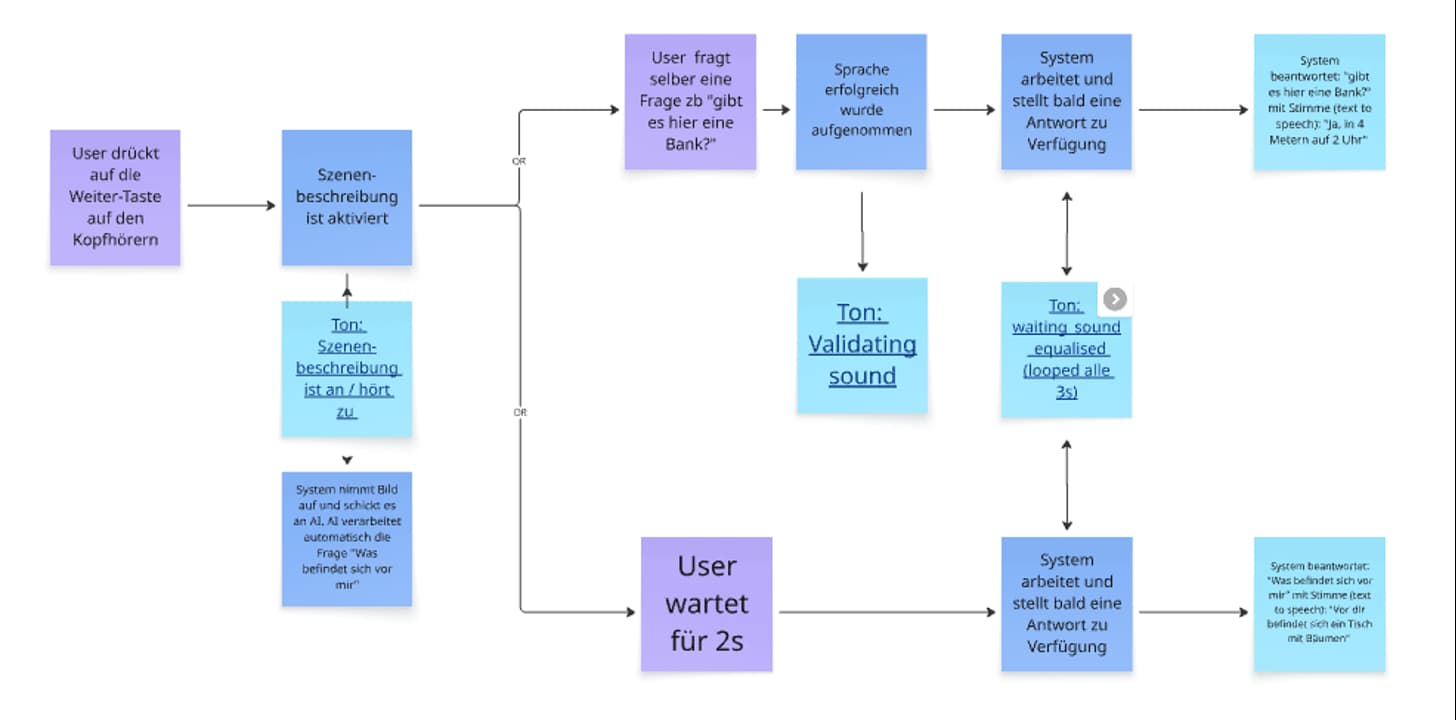

Bildbeschreibung auf Abruf in Audiogames

Ein weiterer Baustein ist die Möglichkeit, gezielt ein Bild der Umgebung beschreiben zu lassen. Moderne Technologien wie Be My Eyes, Be My AI, My AI und Seeing AI nutzen Künstliche Intelligenz, um sowohl Foto- als auch Texte-Erkennung zu ermöglichen und so blinden und sehbehinderten Menschen im Alltag zu helfen. Per Tastendruck am Kopfhörer löst die Person die Smartphone Kamera aus.

Das Foto wird an ein KI System geschickt, das die Szene in Text beschreibt. Dieser Text wird in Sprache umgewandelt und über die Kopfhörer ausgegeben.

So kann ich zum Beispiel sagen lassen, dass vor mir eine Straße verläuft, links eine Bank steht oder rechts ein Gebäude mit Eingang ist. Diese Funktion ist nicht für jede Sekunde gedacht, sondern für Momente, in denen man bewusst mehr Kontext möchte. Sie ergänzt die kurzen akustischen Warnsignale um eine sprachliche Ebene, wenn es nötig ist.

Ausblick

Für die Zukunft sehe ich viele Möglichkeiten. Neue Entwicklungen und fortschrittliche Technologien, wie AI-gestützte Navigation und smarte Assistenzsysteme, werden den Alltag von blinden und sehbehinderten Menschen weiter verbessern.

Kopfhörer mit intelligenter Geräuschunterdrückung könnten Warnsignale von Autos verstärken und unnötigen Lärm dämpfen. Head Tracking könnte helfen, das Klangbild noch natürlicher wirken zu lassen. Spannend wäre auch, Daten externer Systeme zu nutzen. E Scooter kennen ihren Standort meist sehr genau.

Wenn solche Informationen zugänglich wären, könnte man Gefahren schon berücksichtigen, bevor der Lidar Scanner sie sieht.

Die App ist als Ergänzung zu bestehenden Hilfsmitteln wie Blindenhunden oder Langstöcken gedacht und soll die Navigation und Sicherheit weiter erhöhen.

Der Markt für innovative Lösungen wächst stetig, und solche Technologien werden zunehmend weltweit verfügbar, um Menschen mit Sehbehinderung auf der ganzen Welt zu unterstützen.

Trotz dieser Visionen bleibt der Kern des Projekts sehr einfach. Ich möchte, dass blinde Menschen auf ihren vertrauten Wegen ein Stück mehr Sicherheit spüren.

Es geht nicht darum, ihnen die Kontrolle abzunehmen. Im Gegenteil. Das System soll sie dabei unterstützen, eigenständig zu bleiben. Ein kleiner Klick an der richtigen Stelle kann genau das ermöglichen.

Dieser Button führt zu meinen Kontaktdaten