AJO – Das 3D Audio Game als Escape Room

Ich sitze im Studio, setze mir Kopfhörer auf und schalte das Bild aus. Kein Monitor, keine Spielgrafik, nur Schwarz. Vor mir höre ich Schritte in Kies, Stoff, der raschelt, Tropfen, die von einer Decke fallen. Eine Stimme fragt leise, fast nervös. Und, wo lang jetzt? In diesem Moment wird klar: Dieses Spiel existiert nur in meinem Kopf und in meinen Ohren.

Genau darum geht es in diesem Projekt. Ein Game, das auf Bilder verzichtet und stattdessen komplett über Klang erzählt wird. Die Spielfigur heißt AJO. Ich sehe sie nie. Aber ich höre, was sie hört. Ich begleite sie durch Höhlen, Tunnel und enge Räume, indem ich nur einem Medium vertraue: Raumklang.

Das Projekt zeigt, wie innovative Audiotechnologien den Alltag von blinden und sehbehinderten Menschen bereichern und ihre Unabhängigkeit durch immersive Klangwelten stärken können.

Warum

Ein Spiel ohne Bild

Das Ziel war von Anfang an radikal. Ich wollte helfen ein Spiel zu bauen, das vollständig ohne visuelle Ebene funktioniert. Kein Interface, keine Icons, keine Menüs. Nur Audio. Klang als Navigation, als Information, als Emotion.

Die Idee lag nahe, sich an Audiogames anzulehnen. Spiele, bei denen Ton nicht nur Dekoration ist, sondern zentrale Spielmechanik.

Gleichzeitig wollte ich über das klassische Verständnis hinausgehen. Mich interessierten nicht nur einfache Hörspiele mit Auswahlmöglichkeiten, sondern ein echtes räumliches Game, das ich in einer Engine baue und in dem jede Bewegung im Raum auch klanglich spürbar ist.

Zu den besonderen Funktionen des Spiels gehört der gezielte Einsatz verschiedener Audioelemente, die es ermöglichen, Aufgaben zu lösen, die Navigation zu unterstützen und die Orientierung in der Umgebung allein durch Klang zu gewährleisten.

Dabei stand eine Frage im Mittelpunkt: Reicht räumlicher Klang allein aus, um Orientierung, Spannung und eine zusammenhängende Geschichte zu transportieren? Oder fehlen uns ohne Bild zu viele Ankerpunkte?

AJO als Fokusfigur

Um das greifbar zu machen, brauchten wir eine klare Erzählperspektive. So entstand AJO. Sie ist die Protagonistin, die sich durch eine dunkle Welt bewegt. Ich als Spieler sehe nichts. Ich „telefoniere“ mit ihr, höre, was in ihrem Headset ankommt, und gebe Anweisungen. Sie handelt, ich interpretiere.

Die Grundidee war, dass AJO in völliger Dunkelheit unterwegs ist und nur über ihre akustische Wahrnehmung und meine Entscheidungen vorankommt. Wir wollten ein Proof of Concept, der zeigt, dass sich eine narrative Erfahrung vollständig aus räumlicher Tonwahrnehmung aufbauen lässt.

Dabei wird die Sprachausgabe gezielt eingesetzt, um Informationen und Anweisungen an die Spieler weiterzugeben und so eine barrierefreie, akustische Navigation durch die Spielwelt zu ermöglichen.

Inspiration aus der Spielewelt

Auslöser war unter anderem das Spiel Horizon Zero Dawn. Dort gibt es ein Feature namens Focus. Wenn man es aktiviert, verändert sich die Klangwelt. Geräusche von Hinweisen und Gefahren treten in den Vordergrund. Man hört plötzlich besser, wo Gegner sind oder wo ein relevanter Punkt liegt.

Ich habe mich gefragt, wie sich so ein Fokus in ein reines Audioerlebnis übersetzen lässt. Was passiert, wenn ich diesen Gedanken weiterdrehe und komplett auf das Bild verzichte? Kann ich mit etwas wie einem akustischen Sonar durch eine Welt navigieren?

Dabei können gezielt eingesetzte akustische Signale die Orientierung und Navigation unterstützen, indem sie wichtige Informationen über die Umgebung und potenzielle Hindernisse vermitteln.

Wie

Iterativer Aufbau in der Engine

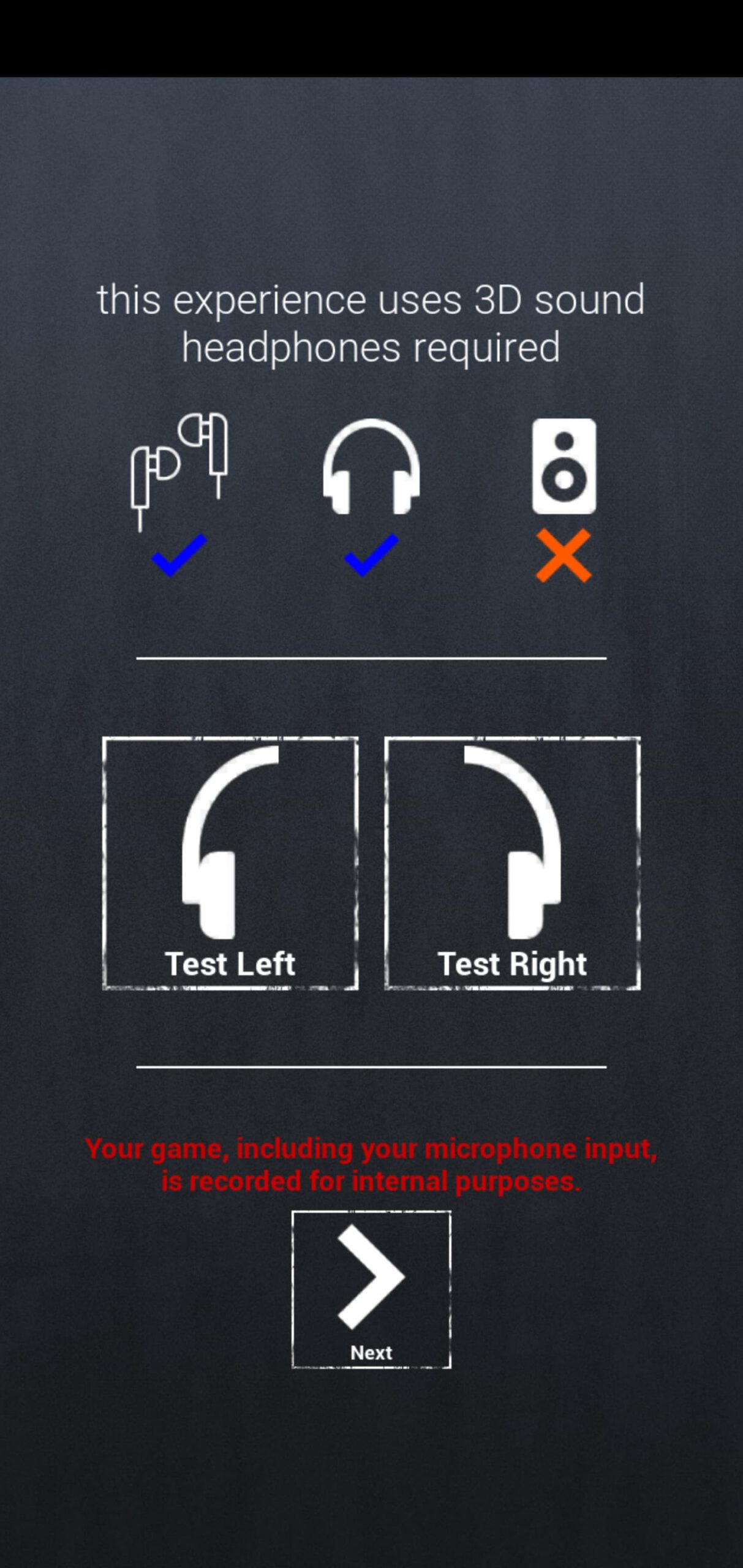

Die Umsetzung fand direkt in Unreal statt. Bereits in der Entwicklung des Projekts wurden moderne Technologien gezielt eingesetzt, um die Unterstützung und Barrierefreiheit für Menschen mit Sehbehinderung zu verbessern. Ich habe mit den Developern in Sprints gearbeitet, immer wieder getestet, verworfen, vereinfacht und neu gebaut. Von Anfang an war klar. Sound darf hier nicht nur schön sein. Er muss funktionieren.

Die Audio Pipeline bestand aus mehreren Bausteinen. Binaurales oder ambisonisches Spatial Audio für die räumliche Abbildung. Interaktive Sonar Sounds für die aktive Navigation. Foley für Schritte, Kleidung und Objekte.

Ambiences für unterschiedliche Räume. Musik, die gezielt emotionale Akzente setzt, aber nicht als Dauerschleife läuft. Und Voice Overs für AJO und andere Figuren, die Hinweise geben und die Geschichte tragen.

Jeder Klang bekam eine Aufgabe. Er sollte Richtung vermitteln. Er sollte Entfernung korrespondierend zur Lautstärke und zum Frequenzgang fühlbar machen. Er sollte Materialien und Raumgröße andeuten.

Klingt der Schritt auf Metall oder auf Kies. Ist der Raum trocken oder hallig. All das musste im Ton lesbar sein.

Phase 1. Orientierung ohne Bild

In Phase 1 haben wir einen sehr reduzierten Aufbau gewählt. Ein kleiner Parcours in der Engine, ein paar Objekte, zum Beispiel ein tropfender Wasserhahn, ein summender Sicherungskasten, ein Vogel als akustische Landmarke.

Die Steuerung lief zunächst über ein simples Interface. Vor, zurück, links, rechts. Der Charakter bewegte sich in Schritten durch die Welt. Die Idee. Ich höre ein Geräusch, bewege mich darauf zu, der Ton wird lauter, die Richtung klarer, ich löse eine Aktion aus und die Geschichte geht weiter.

Akustische Punkte, wie etwa Straßenkreuzungen oder andere markante Orte, dienten dabei als Orientierungshilfen im Spiel und halfen, wichtige Punkte in der Umgebung gezielt wahrzunehmen.

Zusätzlich gab es ein Sonar. Wenn ich nicht mehr weiterwusste, konnte ich eine Art akustischen Ping auslösen.

Die Engine spielte dann für relevante Objekte kurze Hinweise ein, damit ich sie überhaupt erst lokalisieren konnte. So sollten sich im Kopf der Spielenden nach und nach akustische Karten bilden.

Die Realität war deutlich komplizierter. Lokalisierung funktionierte grundsätzlich, aber nur bei sehr klaren Richtungsunterschieden. Vorne, klar links, klar rechts. Alles dazwischen war schwierig.

Eine Drehung um fünfundvierzig Grad war zu fein. Spielerinnen und Spieler wussten oft nicht, ob ein Geräusch noch halb links oder schon vorne war.

Dazu kamen Effekte wie Occlusion. Wenn ein Objekt hinter einer Wand lag, wurde es gedämpft und klang aus einer anderen Richtung als erwartet. Das ist physikalisch plausibel, aber kognitiv schwer zu entschlüsseln, wenn man keinen visuellen Bezug hat.

Manche Quellen wurden trotz Sonar einfach nicht gefunden. Das Vogelnest blieb unsichtbar im Klang. Das Wasser plätscherte zwar, aber nicht eindeutig genug, um gezielt darauf zuzulaufen.

Ohne deutlichen Hall fehlte zudem der räumliche Kontext. Ob ich nah an einer Wand stand oder in der Mitte eines Raumes, ließ sich schwer unterscheiden. Dazu kam, dass mehrere gleichzeitige Geräusche schnell überforderten.

Wenn Sonar drei Hinweise auf einmal ausgab, war unklar, womit man anfangen sollte. Die Navigation war prinzipiell möglich, aber anstrengend und langsam.

Phase 2. Klarere Räume, klarere Logik

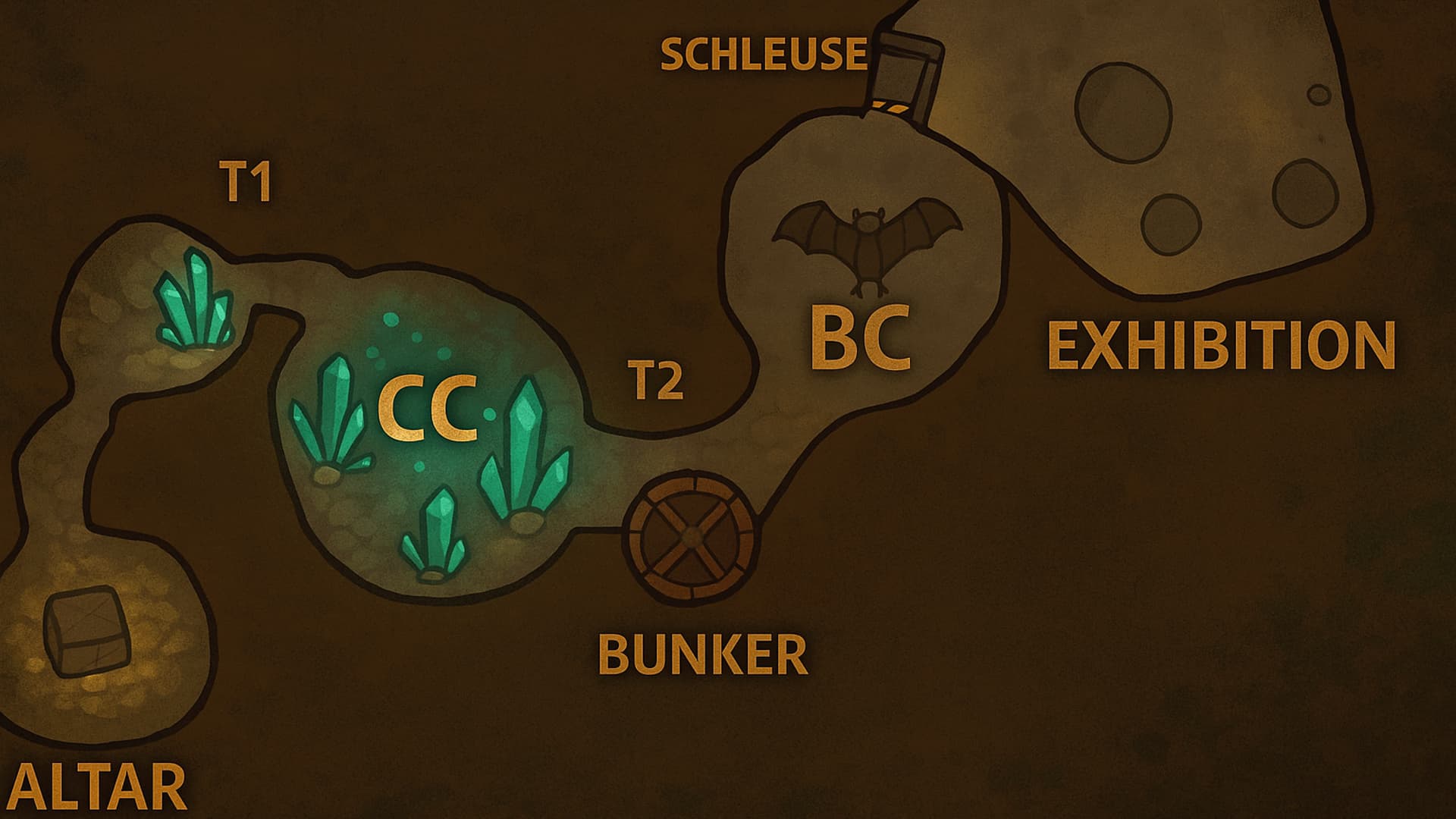

Aus diesen Erkenntnissen habe ich Phase 2 entwickelt. Statt eines abstrakten Parcours entstand eine kleine Spielwelt mit klar getrennten Räumen. Eine Höhle mit Kristallen. Ein Tunnel. Ein Bunkerzugang mit Tür und Kabeln. Eine Schleuse mit Maschinen und Druckklängen. Eine Bat Cave, in der Gegner auf Geräusche reagieren. Eine Ausstellung, die als Ausgangsszene dient.

Die akustische Gestaltung der Umgebung trägt wesentlich dazu bei, dass sich Nutzer besser orientieren und ihre Position im Raum erkennen können.

Jeder Raum bekam ein klares akustisches Profil. In der Kristallhöhle schwingen resonierende Klänge. Im Tunnel dominieren enge Reflektionen. In der Schleuse hört man Wasserstrahlen und schwere Maschinen. So ist schon am Grundrauschen hörbar, wo ich mich ungefähr befinde.

Die Interaktion wurde vereinfacht. Türen, Schalter und Objekte bekamen eindeutige akustische Zustände. Tür zu klingt anders als Tür offen. Ein Kabelbrummen signalisiert Strom.

Wenn ich einen Sonar Ping auslöse, bekomme ich nur noch einen Hinweis zurzeit, nicht mehr mehrere gleichzeitig. Die Spielwelt antwortet quasi chronologisch.

Technisch habe ich Reverb und Occlusion deutlicher gemacht. Wandreflexionen sind nicht mehr ein subtiler ästhetischer Effekt, sondern deutliches Signal.

Dumpfer Klang bedeutet hinter der Wand. Klarer Klang bedeutet frei im Raum. Unterschiedliche Materialien erhielten eigene Klangfarben. Metall klingt anders als Holz oder Stein.

Die Richtungsauflösung habe ich verändert. Statt starrer Schritte in groben Winkeln setze ich auf feinere Bewegungen oder automatische Fokussierung auf relevante Objekte.

Es geht nicht darum, jeden Grad einzeln abzubilden. Es geht darum, dass der Kopf des Spielers versteht: Da vorne ist etwas Wichtiges.

KI im Hintergrund

Ein weiterer Schritt in Phase 2 war die Anbindung an ein Sprachmodell. Eingaben der Spielenden werden an ein Language Model geschickt, das den aktuellen Spielzustand interpretiert.

Dank der fortschrittlichen Intelligenz künstlicher Intelligenz kann das System Nutzer gezielt unterstützen, indem es komplexe Situationen erkennt und passende Hilfestellungen bietet. Die Antworten werden per Text to Speech direkt vertont und im Raum positioniert.

Dadurch kann AJO Fragen beantworten wie. Was siehst du in diesem Raum? Oder: Gibt es hier etwas, das ich benutzen kann?

Die Engine prüft, welche Objekte sichtbar oder aktiv sind, formuliert eine Antwort und gibt sie über AJOs Stimme zurück.

Am Anfang erschien mir dieser Ansatz fast überzogen. Doch je länger ich mit rein auditiver Navigation gearbeitet habe, desto klarer wurde: Ohne solche Hinweise bleibt vieles unverständlich.

Die Kombination aus räumlichem Sounddesign und kontextbezogenen Sprachhinweisen macht die Erfahrung deutlich zugänglicher und reduziert die reine Trial und Error Komponente.

Was

Die Rolle der Spielenden

Im fertigen Prototyp telefonieren die Spielenden mit AJO. Sie hören durch ihr Headset, was sie hört. Sie selbst sind nicht in der Welt, sondern eher eine Art Operator im Hintergrund.

Sie geben Orientierung, AJO setzt sie um. Dabei unterstützen die Spielenden AJO aktiv bei der Bewältigung von Aufgaben, indem sie ihr helfen, alltägliche Herausforderungen zu meistern.

Die Kommunikation funktioniert über Stimme, Geräusche und Sonar. Die Spielenden lauschen, ziehen Schlüsse und geben Anweisungen. AJO kommentiert, zweifelt, reagiert. So entsteht eine Beziehung, die ganz ohne Bild auskommt.

Räume als akustische Szenen

Die Spielwelt besteht aus mehreren klar voneinander getrennten Szenen. Am Altar findet AJO ein Artefakt, das als Auslöser der Geschichte dient. Im ersten Tunnel wird die grundlegende Navigation getestet.

In der Kristallhöhle dienen schwingende Steine als akustische Landmarken. An der Bunker Tür entsteht ein Puzzle aus Kabelgeräuschen, Metallklängen und Sonar Hinweisen. In der Bat Cave reagieren Gegner auf Lärm, was das Thema Lautstärke als Gameplay Element stärkt.

In der Schleuse treffen Wasser, Druck und Mechanik aufeinander. Am Ende in der Ausstellung trifft AJO auf ein System, das sie zu erkennen scheint.

Jeder Raum besteht aus mehreren Audioebenen. Ambience, die in sechs Freiheitsgraden in Unreal verteilt wird. Sonar Interaktionen, die Objekte und Zustände hörbar machen.

Foley für alle Bewegungen und Handlungen. Dialoge für AJO und Begleitfiguren. Musik nur punktuell als dramaturgischer Verstärker. Die verschiedenen Audioebenen vermitteln gezielt Informationen über die Umgebung und die jeweilige Situation, um die Orientierung und das Verständnis der akustischen Szene zu unterstützen.

Herausforderungen

Die größte Herausforderung war, dass Orientierung nur über Ton nur dann funktioniert, wenn jeder Sound klare Information transportiert. Es darf kaum akustischen Ballast geben.

Alles, was man hört, muss entweder zur Stimmung oder zur Orientierung beitragen, im besten Fall zu beidem. Besonders bei der Entwicklung der akustischen Orientierung traten spezifische Probleme auf, etwa wie Richtungsinformationen und Entfernungen eindeutig und verständlich vermittelt werden können, ohne den Nutzer zu überfordern.

Da kein Headtracking verwendet wurde, musste ich Richtungsinformationen über andere Mittel vermitteln. Sonar Samples, Lautstärkeverläufe, Filter, Hall und Timing. Entfernung und Position mussten über diese Parameter lesbar werden. Gleichzeitig durfte das Ganze den Kopf nicht überfordern.

Hinzu kam, dass Storytelling und Gameplay sich gegenseitig tragen mussten. Es gibt keinen Moment, in dem eine Grafik einspringt, um etwas zu erklären. Wenn eine Tür geöffnet ist, muss man das hören. Wenn ein Rätsel gelöst ist, muss sich die Klangwelt verändern.

Ein weiterer wichtiger Punkt war die Struktur der Audio Pipeline. Bei hunderten von Soundobjekten reichen spontane Benennungen nicht aus.

Klare Naming Konventionen, saubere Ordnerstrukturen und modulare Setups waren notwendig, um im Team iterativ arbeiten zu können, ohne den Überblick zu verlieren.

Fazit

Der Prototyp zeigt, dass komplexes Raumgefühl, Spannung und eine ganze Geschichte allein über Audio funktionieren können. Navigation ohne Bild ist möglich, wenn Sounddesign konsequent funktional gedacht wird.

Für mich persönlich war das Projekt eine Art Labor. Ein Ort, an dem ich testen konnte, wie weit ich mit Klang gehen kann, wenn ich ihm die gesamte Verantwortung überlasse. Die Antworten sind nicht immer bequem. Vieles ist kognitiv anspruchsvoller, als wir es gewohnt sind. Aber genau das macht den Reiz aus.

Die Vorteile dieses Projekts liegen besonders darin, blinden und sehbehinderten Menschen einen barrierefreien Zugang zu immersiven Medien zu ermöglichen und ihnen neue, eigenständige Erlebnisse zu bieten.

Zurück zum Blog