Wie binaurales Audio funktioniert um 3D Sound zu lokalisieren

Inhalt

In den letzten Jahren habe ich immer wieder Bachelor- und Masterarbeiten betreut oder ein Experteninterview gegeben. Als Grundlage für ihre Arbeit haben fast alle Studierenden ein Kapitel über das räumliche Hören geschrieben. Verwunderlich ist das nicht, ist “räumliches Hören” doch DIE Grundlage für alle Audiobereiche. Daher dachte ich es mir es ist eine gute Idee, das gesammelte Wissen hier an einer Stelle zusammenzutragen.

Auch wenn auf den ersten Blick recht theoretisch wirken mag, und es teilweise recht wissenschaftlich wird, möchte ich das Thema möglichst auch für nicht-Audio Leute verständlich machen. Aber zugegeben, es wirkt auf den ersten Blick recht theoretisch. Der Inhalt stammt verstreut aus verschiedenen und auch meiner Arbeit. Wer also Verbesserungsvorschläge zum Thema räumliches Hören in Bezug auf 3D Audio hat, kann sich gerne melden.

Aber zur Motivation zum Weiterlesen: unser Gehirn schafft das Ganze mit nur zwei Ohren, einer faszinierend geprägten Ohrmuschel und komplexen Prozessen zwischen unseren Lauschern. Damit entsteht etwa die Faszination für Live-Musik, oder es wird im Alltag auf Gefahren hingewiesen, die wir nicht sehen können. Schon spannend!

Räumliches Hören – was ist das?

Das räumliche Hören beschreibt die Fähigkeit des menschlichen Gehörs, die Umgebung dreidimensional wahrzunehmen. Unser Hörsinn, oder genauer gesagt unsere auditive Wahrnehmung, setzt sich grundlegend aus folgenden Aspekten zusammen:

- der mechanischen Schallverarbeitung,

- der Schallaufnahme,

- der neuronalen Umsetzung über die Hörbahn und letztendlich

- der kognitiven Verarbeitung im Gehirn

Die Wahrnehmung von Schall durch zwei Ohren wird auch als binaurales Hören bezeichnet und stattet uns mit der Fähigkeit zur Schallortung und dem Richtungshören aus.

Für 3D Audio reichen im kleinsten Fall zwei Audiokanäle

Auch wenn gern etwas anderes behauptet wird – es reichen tatsächlich zwei Ohren, um Ton auch etwa hinter uns wahrzunehmen, dreidimensional eben. Daher bin ich so ein großer Fan von “Kopfhörer 3D”, also dem bereits erwähnten binauralem Klang. Doch wie kann das unser Gehirn, ganz ohne technische Hilfsmittel wie Hörgeräte?

Die Ebenen des Hörens

Das Gehörte wird lokalisiert, indem Schallrichtung, -entfernung und -pegel am linken und rechten Ohr miteinander verglichen und durch unser Gehirn interpretiert wird.

Um die Beschreibung solcher Hörereignisse besser definieren und abbilden zu können, wird der dreidimensionale Raum auf ein kopfbezogenes Koordinatensystem übertragen und in drei einzelne Ebenen aufgeteilt. Diese bilden jeweils zwei Dimensionen der X, Y und Z Achse ab:

- Die Horizontalebene: Befindet sich in der Horizontalen und steht für die Signalwege rechts, links, hinten und vorne.

- Die Frontalebene: Geht um die Ohren und den Hals herum und definiert den Bereich links, rechts, unten und oben.

- Die Medianebene: Hat einen Verlauf über die Nase, den Hals sowie den Hinterkopf und steht für die Richtungen hinten, vorne, unten und oben.

Die Lokalisation erfolgt aber nicht nur nach unterschiedlichen Eigenschaften vom Gehör und der damit verbundenen Signalverarbeitung des Gehirns. Es ist vielmehr eine Kombination aus unterschiedlichen Lokalisationsmechanismen, welche es einem ermöglichen, richtungsgenau und schnell die Schallquelle zu bestimmen.

Durch die Polarkoordinaten Azimuth, Elevation und der Entfernung, kann ein lokalisiertes Schallereignis auf ein mathematisches Modell angewendet werden. Dies lässt sich dann in einem Koordinatensystem mit X-, Y- und Z-Achse abbilden. Um eine annähernd genaue Lokalisation des Schallereignisses zu erzielen, muss diese binaural, also mit zwei Ohren erfolgen. Daraus geht hervor, dass die Lokalisation auf Horizontal- und Vertikalebene auf unterschiedliche Weise funktioniert. Genug Mathematik fürs Erste!

Wie funktioniert die Lokalisation auf der horizontalen Ebene?

Bei der Horizontalebene sorgen die Laufzeitunterschiede zwischen dem Eintreffen des Schallsignals an beiden Ohren sowie frequenzabhängige Pegelunterschiede beider Ohren für die Lokalisation des Hörereignisses. Beim natürlichen Hören entstehen sowohl interaurale Laufzeit- als auch frequenzabhängige interaurale Pegeldifferenzen, dazu später mehr.

Wie funktioniert die Lokalisation auf der vertikalen Ebene?

Auf der vertikalen Ebene, der sogenannten Medianebene, welche sich auf der Symmetrieebene des Kopfes befindet, erfolgt die Lokalisation nicht durch Laufzeit- oder Pegeldifferenzen, sondern mit Hilfe von Klangfarbenunterschieden, die sich auf die Klangfarbe der Blickrichtung des eintreffenden Signals beziehen und durch die Beschaffenheit von Kopf und Ohren bestimmt werden. Somit werden richtungsbestimmende Frequenzbänder nach Einfallsrichtung angehoben.

Die Definition von Schall

Es gilt für Physiker, die Komponente Schall aus mehreren Perspektiven zu betrachten und zu definieren. Physikalisch definiert ist Schall eine Schwingung in Druck, Spannung, Partikelverschiebung, Partikelgeschwindigkeit usw., die sich in einem Medium mit inneren Kräften (z.B. elastisch oder viskos) ausbreitet, oder die Überlagerung einer solchen sich ausbreitenden Schwingung. Die Hörempfindung wird hervorgerufen durch die beschriebene Schwingung. Klingt wie eine Beschreibung aus dem Lehrbuch – ist aber eigentlich gar nicht so kompliziert.

Schall in der Physik

Schall kann also als mechanische Schwingungen betrachtet werden, die sich in Form von Wellen (Schallwellen) in einem elastischen Medium (z.B. Luft oder Wasser) ausbreiten. Schall ist die objektive Ursache des Hörens. Im Gegensatz zu flüssigen und gasförmigen Medien, wo sich Schall nur in Form von longitudinalen Wellen ausbreitet, kommen in Festkörpern auch transversale Wellen hinzu. Longi…was? Zugegeben, das sprengt jetzt den Rahmen vom räumlichen Hören für 3D Audio, daher gehen wir hier auf die Wellenarten nicht weiter an. Es steht aber im Internet genug dazu.

Umgangssprachlich bezeichnet Schall vor allem das Geräusch, den Ton oder den Klang, wie er von Menschen und Tieren mit dem Gehör auditiv wahrgenommen werden kann. Schall soll aber ebenso als die vom Gehör wahrgenommene Empfindung verstanden werden.

Ton kann man nicht nur hören, sondern auch fühlen

Zusammengefasst gibt es mehrere Definitionen, die auf das Phänomen Schall zutreffen. Während die technische Herangehensweise auf sehr visuelle Weise veranschaulicht, was passiert, wenn wir Schall wahrnehmen (eine Schallwelle schwingt in einem Medium), kann Schall aber auch als Sinnesreiz unseres Hörorgans betrachtet werden. Dieser löst wiederum Emotionen und weitere Reize aus. Töne, Klänge, Geräusche usw. können also nicht nur gehört, sondern auch empfunden oder gefühlt werden. Beide Betrachtungsweisen sind wichtig für das Grundverständnis von Schall und dafür, wie er vom menschlichen Gehör wahrgenommen wird.

Grundlagen der Raumakustik

Jeder Raum hat akustische Eigenschaften und Informationen sowie Auswirkungen auf ein Schallereignis, das in ihm stattfindet. Einige davon können als Vorteil genutzt werden und andere müssen minimiert werden, um eine saubere Aufnahme eines Konzerts oder eines Filmdialogs zu erhalten. Mit anderen Worten: ein großer Kirchensaal ist wegen der Menge an Hall und Reflexionen nicht unbedingt der beste Ort, um einen schnellen und laut gesprochenen Dialog aufzunehmen. Andererseits erhält eine Aufnahme eines Refrains in einem akustisch trockenen Studioraum nicht diesen epischen Klangcharakter durch natürliche Raumreflexionen.

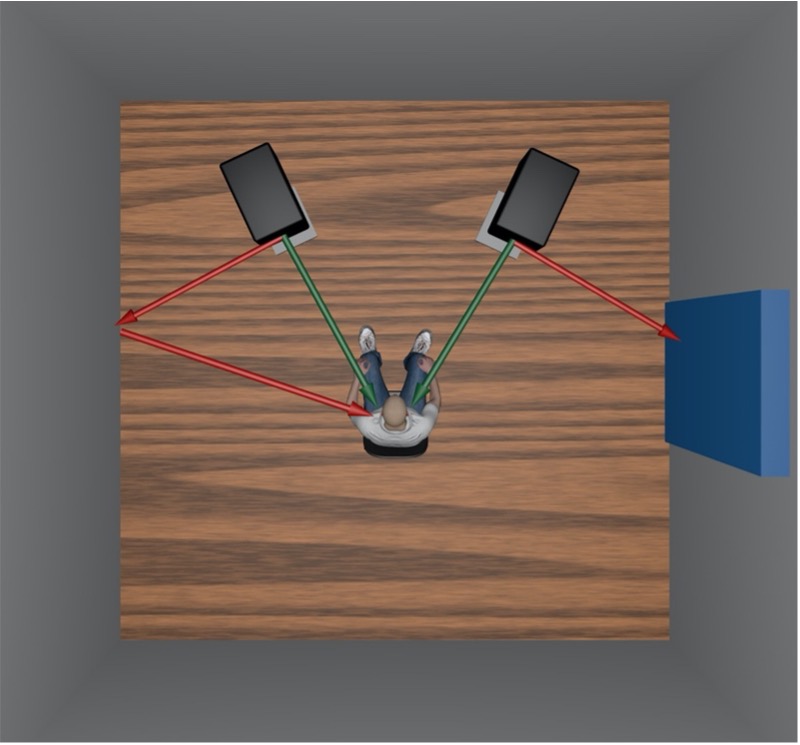

Um eine Vorstellung davon zu bekommen, wie sich Schall in einem geschlossenen Raum ausbreitet, stellt die nachfolgende Grafik das Verhalten von Direktschall, frühen Reflexionen und der Absorption dar.

Es ist also nicht nur der bereits erwähnte Unterschied des Direktschalls in Sachen Laufzeit, Schalldruck etc. ausschlaggebend. Gerade beim Mischen in 3D Audio merke ich, wie wichtig auch die Reflexionen (Erstreflexionen, Nachhall) eines Raumes sind. Das Tool DearVR hat etwa diese Kombination aus 3D Lokalisation und entsprechenden Hall.

Die meisten 3D Audio Plugins machen meist nur Panning. Sprich anhand von Koordinaten oder Metadaten platziert man ein Audio-Objekt in einem 3D Raum. Auch wenn Dolby Atmos und Ambisonics technisch gesehen sehr unterschiedliche Audioformate sind, machen sie hier fast das Gleiche. Der Sound kommt jetzt zwar aus einer bestimmten Richtung, diesem fehlt aber ein Bezugssystem, welches auch erklärt nicht nur wo im Raum, sondern in welchem Raum es sich befindet.

Wie entsteht Direktschall?

Eine Schallquelle in einem geschlossenen Raum strahlt Schallwellen in viele verschiedene Richtungen ab. Diese Schallwellen gelangen auf unterschiedliche Weise zum Hörort. Als Direktschall werden jene Schallwellen bezeichnet, die den kürzesten Weg zwischen Schallquelle und Ursprungsort des Hörers nehmen.

Wie bilden sich Reflexionen und Diffusschall?

Wird die Schallwelle einer Quelle von einer oder mehreren Oberflächen reflektiert, bevor sie den Hörer erreicht, spricht man von Reflexionen. Die sogenannten Frühreflexionen oder Early Reflections sind jene, welche an den nächstgelegenen Raumbegrenzungen reflektiert werden. Folgen diese Reflexionen so dicht aufeinander, dass sie nicht mehr als Einzelreflexionen wahrzunehmen sind, spricht man von Diffusschall.

Wann ist die Rede von Absorption?

Zusätzlich zu den Reflexionen treten je nach Oberfläche auch Absorptionen des Schalls auf. Ist eine Oberfläche schallhart (harte Materialien wie Stein, welche nicht mitschwingen), so wird beim Auftreffen des Schalls relativ wenig Energie entzogen. Ist der Absorptionsgrad einer Oberfläche hoch (etwa bei Sofas, Vorhängen), so wird ein großer Teil der akustischen Energie in Wärmeenergie umgewandelt. Dem Schall wird also Energie entzogen. Während zum Beispiel Glas oder Beton einen niedrigen Absorptionsgrad aufweisen, ist er bei Teppichen oder Schaumstoffmaterialien sehr hoch. Der Absorptionsgrad beschreibt das Verhältnis zwischen absorbierter Energie und Energie der auftreffenden Schallwelle und gibt an, wie gut das Absorptionsvermögen eines Materials ist.

Welchen Einfluss hat die Nachhallzeit?

In einem geschlossenen Raum wird ein Schallereignis mehrmals reflektiert, bevor es schließlich so wenig Pegel erreicht, dass es nicht mehr wahrnehmbar ist. Die Nachhallzeit beschreibt also die Zeit, in der der Schalldruckpegel (SPL) des Nachhalls um 60 dB unter den Originalschalldruck abgesunken ist. Deshalb wird die Nachhallzeit auch als RT60 bezeichnet (engl. Reverberation Time = Nachhallzeit).

Sie spielt eine wesentliche Rolle beim Klangcharakter eines Raumes. Sprecher- und Gesangskabinen besitzen etwa eine maximale Nachhallzeit von 0.3 Sekunden. Damit erhält manbei einer Aufnahme den Direktschall möglichst unverfälscht. Als anderes Extrem werden oft auch Orte wie zum Beispiel große Kirchen für Aufnahmen verwendet, um von den Raumcharakteristika wie etwa der Nachhallzeit zu profitieren und der Aufnahme einen bestimmten Klang zu verleihen. Hier kann die Nachhallzeit gerne mal mehrere Sekunden lang sein. Die Nachhallzeit spielt demnach bei Mikrofonaufnahmen eine sehr wichtige Rolle und sollte stets berücksichtigt werden, um qualitativ hochwertige Ergebnisse zu erzielen.

Grundlagen der Psychoakustik und psychoakustischer Effekte

Psychoakustik ist eine Wissenschaft für sich. In unserem Kopf passieren bei der Schallverarbeitung unerwartete Phänomene, die wir mit klassischer Physik nicht so einfach erklären können. Eigentlich müsste man dafür einen eigenen Artikel schreiben. Aber hier mal ein kurzer Anschnitt in Sachen räumliches Hören und 3D Audio.

Wie funktioniert das menschliche Ohr?

Das menschliche Ohr enthält, wie auch bei anderen Säugetieren, Sinnesorgane, die zwei ganz unterschiedliche Funktionen erfüllen: die des Hörens und die des Haltungsgleichgewichts und der Koordination von Kopf- und Augenbewegungen.

Anatomisch besteht das Ohr aus drei unterscheidbaren Teilen: dem Außen-, Mittel- und Innenohr. Das äußere Ohr besteht aus dem sichtbaren Teil, der Ohrmuschel (Helix), welche seitlich am Kopf hervorsteht, und dem kurzen äußeren Gehörgang, dessen inneres Ende durch das Trommelfell (tympanic membrane) verschlossen ist.

Die Funktion des Außenohrs besteht darin, Schallwellen zu sammeln und zum Trommelfell zu leiten. Das Mittelohr ist ein schmaler, luftgefüllter Hohlraum im Schläfenbein. Es wird von einer Kette aus drei winzigen Knochen überspannt – Hammer, Amboss und Steigbügel, die zusammen als Gehörknöchelchen bezeichnet werden. Diese Gehörknöchelchenkette (auditory ossicles) leitet den Schall vom Trommelfell zum Innenohr, das seit Galen (2. Jahrhundert n. Chr.) als Labyrinth bekannt ist. Es ist ein kompliziertes System von flüssigkeitsgefüllten Durchgängen und Hohlräumen tief im Inneren des Schläfenbeins.

Das Innenohr besteht aus zwei Funktionseinheiten: dem Vestibularapparat, bestehend aus Vestibül und Bogengängen, der die Sinnesorgane des Haltungsgleichgewichts enthält; und die schneckenhausartige Cochlea, die das Sinnesorgan des Hörens enthält. Diese Sinnesorgane sind hochspezialisierte Endigungen des achten Hirnnervs.

Außen- und Mittelohr dienen also grundsätzlich der mechanischen Aufnahme, Filterung und Verstärkung des Schalls, der durch die Ohrmuschel aufgenommen wird. Die Übertragung der Schallwellen an unser Gehirn wird jedoch von über 18.000 Härchen übernommen, welche mit einer Flüssigkeit bedeckt sind und sich in der Hörschnecke im Innenohr befinden.

Psychoakustische Effekte

Im Blog-Beitrag Personalisiertes 3D-Audio – Der heilige Gral namens HRTF wird darauf eingegangen wie räumliches Hören möglich ist. Doch, obwohl Aufbau und Funktion des menschlichen Gehörs umfangreich erforscht sind, bleibt die Wahrnehmungsverarbeitung im Gehirn ein noch nicht abschließend geklärtes Thema.

Verschiedene Modelle und Theorien, basierend auf Experimenten und Beobachtungen des Hörens von Proband*innen haben zu mehreren Erkenntnissen im Bereich der räumlichen Maskierungseffekte und der Wahrnehmung von Musik und Sprache geführt.

Was ist die Duplex Theorie?

Die von Lord Rayleigh (1907) entwickelte Duplex -Theorie beschreibt die Fähigkeit des Menschen, Schallereignisse mit Hilfe von Laufzeitdifferenzen (engl. Interaural Time Differences ITDs) und Pegeldifferenzen (engl. Interaural Level Differences ILD) zwischen linkem und rechtem Ohr zu lokalisieren.

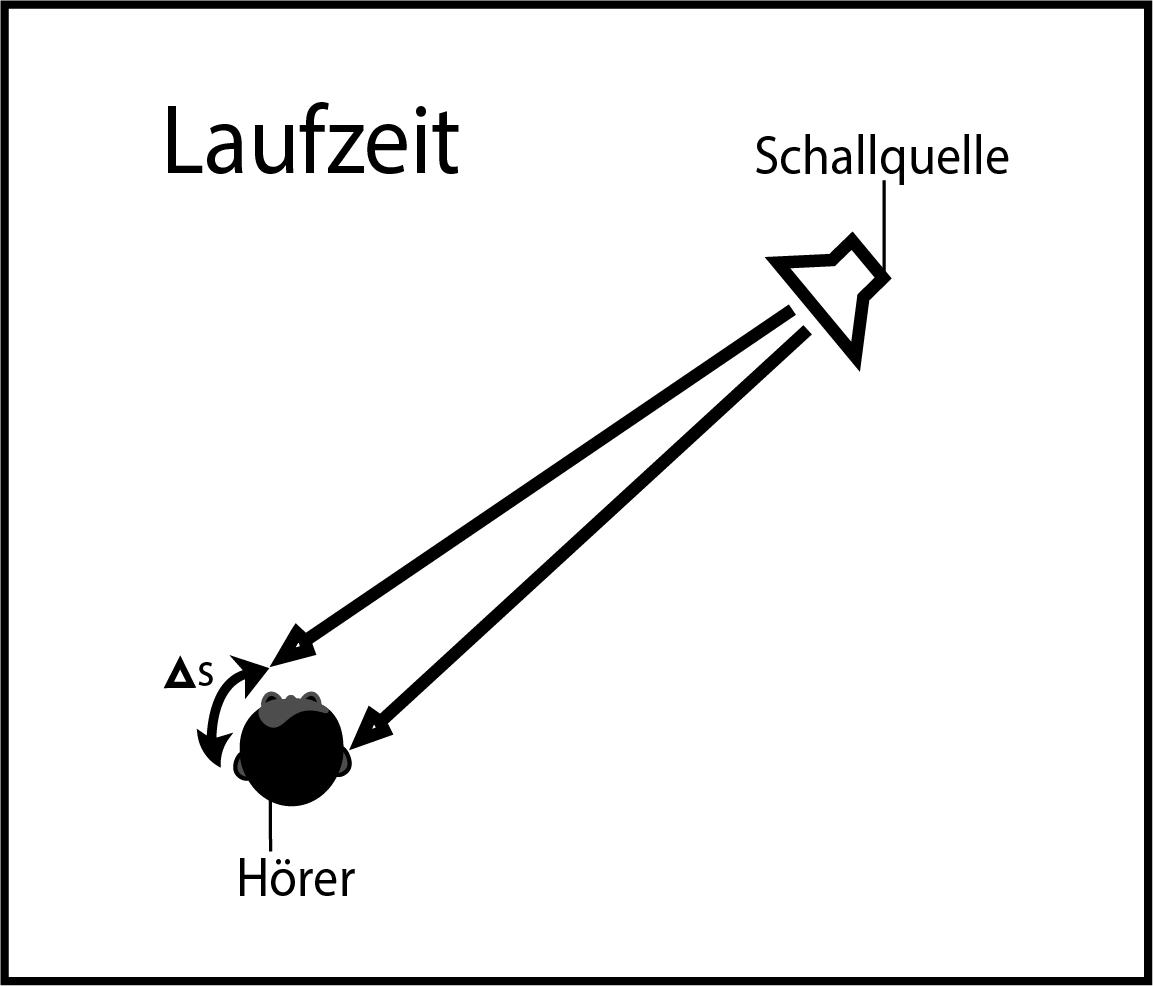

Was ist die interaurale Laufzeitdifferenz (ITD)?

Die interaurale Laufzeitdifferenz resultiert aus der räumlichen Trennung der Ohren durch den Kopf. Die räumliche Trennung verursacht richtungsabhängige Unterschiede der Weglängen, die der Schall von der Quelle zurücklegen muss, um jedes Ohr zu erreichen. Unterschiedliche Ankunftszeiten des Schalls an den beiden Ohren verursachen in weiterer Folge Laufzeitunterschiede. Der maximale Zeitunterschied zwischen linkem und rechtem Ohr beträgt 0,63 ms, was der Größe eines menschlichen Kopfes (ca. 17-20 cm) entspricht. ITDs sind hauptsächlich in einem Bereich unter 1200 Hz wirksam.

Für das natürliche Hören sind interaurale Laufzeitdifferenzen die wichtigsten Merkmale zur Lokalisierung von Schallereignissen oder -quellen.

Was ist die interaurale Pegeldifferenz (ILD)

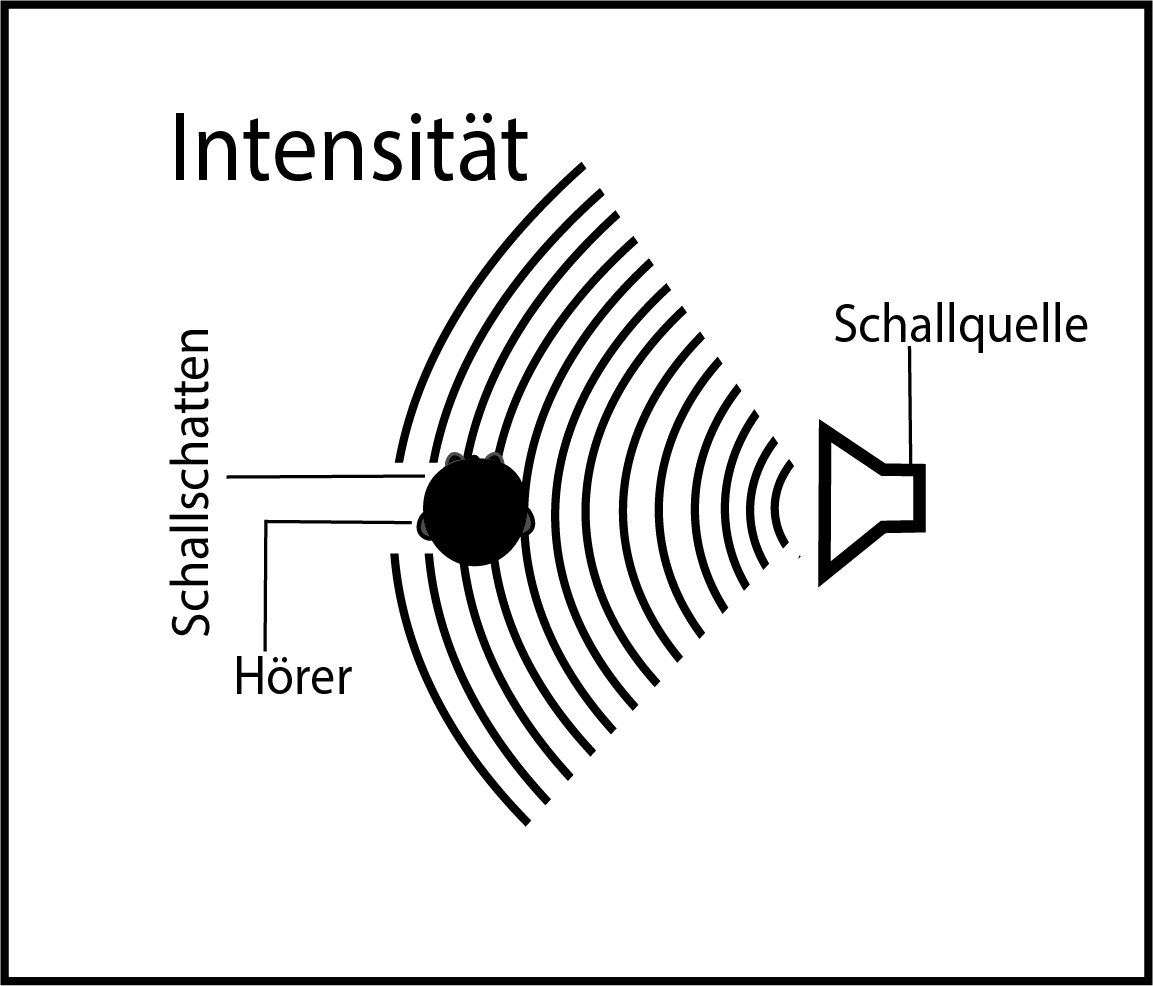

Wie bereits erwähnt, werden interaurale Pegelunterschiede durch einen Abschattungseffekt des Schalls durch den menschlichen Kopf erzeugt. Befindet sich rechts eine Schallquelle, wird das linke Ohr vom Kopf abgeschattet. Das verursacht einen Intensitätsunterschied beim wahrgenommenen Schall zwischen den beiden Ohren und ist ein wesentlicher Faktor für die Lokalisierung von Schallquellen. Die Genauigkeit der Richtungsortung beträgt ein Grad für Quellen vor dem Hörer und 15 Grad für Quellen seitlich. ILDs sind hauptsächlich in einem Bereich über 1600Hz wirksam.

Die Duplex Theorie von Rayleigh und deren beschriebene Zusammenhänge spielen eine wesentliche Rolle für die Lokalisierung von Schall. Wenn jedoch beispielsweise zwei akustische Quellen symmetrisch auf der rechten Vorder- und rechten Hinterseite des menschlichen Kopfes angeordnet sind, erzeugen sie basierend auf der Duplextheorie gleiche ITDs und ILDs, was als Kegelmodelleffekt bezeichnet wird. Dasselbe gilt auch wenn die Schallquelle vertikal, also nach oben und unten versetzt wird. Dennoch ist das menschliche Ohr im Stande, diese Quellen tatsächlich zu unterscheiden. Winkelabhängige Resonanzerscheinungen, welche am Außenohr auftreten, ermöglichen eine Lokalisation auch in vertikaler Ebene. Die Form der Ohrmuschel ist maßgeblich für die Unterscheidung von vorne und hinten verantwortlich.

In anderen Worten: HRTF beschreibt die komplexe Filterwirkung von Kopf, Rumpf und Ohrmuscheln, die eine Lokalisation ermöglichen. Die frequenzbezogenen Anhebungen und Absenkungen, die durch das Außenohr entstehen und bei der Lokalisation von vorne/hinten/oben eine wichtige Rolle spielen, sind in den richtungsbestimmenden Bändern von Jens Blauert näher erläutert.

Die Blauertsche Bänder

Die richtungsabhängige Änderung des Schalls durch Blauerts Bänder kann elektronisch simuliert werden, um eine virtuelle Wahrnehmung dafür zu schaffen, woher ein akustisches Ereignis kommt. Mehrere Frequenzbereiche können eingestellt werden, um den Effekt einer Schallquelle vor, hinter oder über dem Hörer zu erzielen.

Wie nachfolgend dargestellt:

-

Front: sehr präsent, nah, direkt, oberflächlich – Kann durch Verstärkung der Frequenzen in einem Bereich von 300 bis 400 Hz und 3 bis 4 kHz sowie durch Abschwächen von Frequenzen um 1 kHz erreicht werden.

-

Hinten (und oben): diffus, entfernt, räumlich – Kann durch Verstärkung der Frequenzen um 1 kHz erreicht werden.

Im Allgemeinen werden diese Zunahmen und Abnahmen in den Richtungsbändern von Blauert beschrieben, obwohl der Zustand der Nullpunkte in den Resonanzeffekten eines Individuums sehr unterschiedlich ist.

Da für die HRTF-Lokalisierung hauptsächlich Reizmuster zu trainieren sind, welche auf anatomische Unterschiede zurückzuführen sind, kann eine verallgemeinerte Funktion nicht bereitgestellt werden. Auch Methoden wie die Kunstkopf-Stereofonie sind eine Herausforderung, da der Unterschied zum Kopf der Hörer*innen meist groß ist.

Bei der Lautsprecherwiedergabe auf Basis von Phantomschallquellen führt die komplexe Filtercharakteristik der menschlichen Ohrmuschel zu erheblichen Fehlern. Der Grund dafür ist, dass die Winkel der eingehenden Schallwellen nicht mit dem ursprünglichen Schallfeld übereinstimmen. Eine Folge dieses Phänomens sind große Amplitudenfehler, die unter anderem bei Lautsprecherstereofonie zu einer Anhebung der Phantomquelle (Mitte) führen. Abhilfe schafft nur die Rekonstruktion des ursprünglichen Schallfeldes.

Insgesamt lässt sich festhalten: Hören ist ein spannender und komplexer Sinn, und es ist immer wieder faszinierend, wozu unser Körper fähig ist. Dies war nun ein „kleiner“Ausflug in die Welt des räumlichen Hörens. Ich hoffe, dass es nebst all der Theorie dem einen oder der anderen Leserin spannende Hintergrundinformationen vermitteln konnte. Denn all die beschriebenen Punkten bilden die Grundlage für meine tägliche Arbeit mit 3D Audio.

Doch was kann man damit nun Tolles und Unerhörtes machen? Frag mich doch einfach!

Mehr über 3D Audio